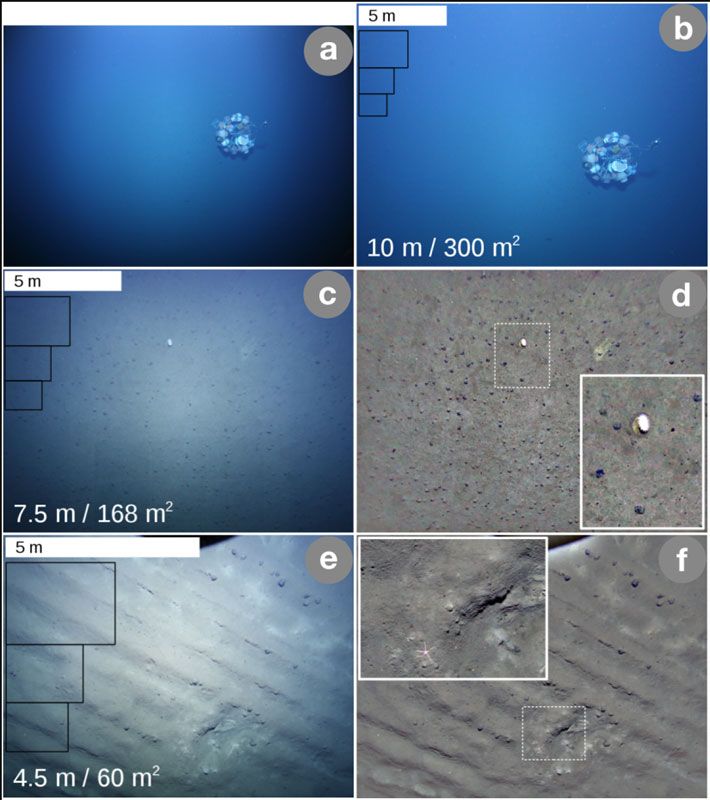

Aufnahmen des AUV ABYSS vom pazifischen Meeresboden aus 10, 7,5, und 4 Metern Abstand. Die Bilder a und b zeigen einen stationären Lander, auf c bis f sind Manganknollen zu sehen, erkennbar als dunkle Punkte am Meeresboden.

Kiel – Die Tiefsee gilt großteils immer noch als Terra incognita. Gerade einmal fünf Prozent des Gesamtvolumens der Weltmeere sind heute erkundet. Um dies zu ändern, setzen Wissenschafter zunehmend auf Roboter. Diese sollen in Zukunft in noch größerem Umfang die Ozeane durchstreifen und Daten sammeln. Doch wer soll diese gewaltigen Datenmassen analysieren? Die Experten hoffen auf die Mithilfe von intelligenten Systemen: Wissenschafter des GEOMAR Helmholtz-Zentrums für Ozeanforschung Kiel haben nun erstmals einen standardisierten Arbeitsablauf für die nachhaltige Analyse mariner Bildaufnahmen entwickelt und ihn in der Fachzeitschrift "Scientific Data" präsentiert.

Hintergrund der Studie war das Projekt JPIOceans "Mining Impact". Um das Ökosystem rund um Manganknollen im Pazifik zu untersuchen, wurde das Autonome Unterwasserfahrzeug ABYSS mit einem neuen, digitalen Kamerasystem ausgestattet. Mit den so gesammelten Daten wurde der Workflow konzipiert und erstmals getestet. Das Vorgehen gliedert sich dabei in drei Schritte: Datenerhebung, Datenverarbeitung und Datenspeicherung, in denen jeweils festgelegte Zwischenschritte absolviert werden sollten.

Verknüpfte Daten

Wichtig ist beispielsweise festzulegen, wie die Kamera einzustellen ist, welche Daten erfasst werden, oder welche Beleuchtung sinnvoll ist um eine bestimmte wissenschaftliche Fragestellung beantworten zu können. Dazu müssen insbesondere auch die Meta-Daten des Tauchroboters aufgezeichnet werden. "Für die Datenverarbeitung ist es essentiell, die Bilddaten der Kamera mit den Metadaten des Tauchroboters zu verknüpfen", sagt Timm Schoening, Erstautor der Arbeit.

Das AUV ABYSS erfasste beispielsweise automatisiert seine Position, die Tiefe des Tauchgangs und Eigenschaften des umliegenden Wassers. "All diese Informationen müssen mit dem jeweiligen Bild verknüpft werden, da sie wichtige Hinweise für die anschließende Auswertung liefern", sagt Schoening. Eine gewaltige Aufgabe: in rund 30 Tauchgängen sammelte ABYSS gut 500.000 Aufnahmen des Meeresbodens. Für die Zusammenführung der Daten sorgten verschiedene Programme, die das Team eigens für diesen Zweck entwickelte. Hier wurde auch unbrauchbares Bildmaterial, das zum Beispiel verwackelt ist, aussortiert.

All diese Prozesse funktionieren jetzt automatisiert. "Bis dahin war allerdings eine Vielzahl an zeitaufwändigen Versuchen notwendig", sagt Schoening. "Jetzt kann die Methode auf beliebige Projekte, auch mit anderen AUVs oder Kamerasystemen, übertragen werden." Das so bearbeitete Material wurde im Anschluss auf öffentlich zugänglichen Plattformen dauerhaft weltweit bereitgestellt.

Künstliche Intelligenz wertet aus

Für die Auswertung am GEOMAR kam schließlich künstliche Intelligenz in Form des eigens entwickelten Algorithmus‘ "CoMoNoD" zum Einsatz. Er erfasst automatisch, ob, in welcher Größe und an welcher Position, Manganknollen in einem Foto vorliegen. Im Anschluss konnten so beispielsweise die einzelnen Aufnahmen zu größeren Karten des Meeresbodens zusammengesetzt werden.

Der nächste Einsatz des Workflows und der neu entwickelten Programme ist bereits geplant: Bei der kommenden Ausfahrt im Frühjahr 2019 in Richtung Manganknollen soll die Auswertung des Bildmaterials dann direkt an Bord erfolgen. "Dafür werden wir einige besonders leistungsfähige Rechner mit auf das Schiff nehmen", sagt Schoening. (red, 12.9.2018)