STANDARD: Sie sagen, der Wettbewerb zwischen Mensch und Roboter ist längst eröffnet. Inwiefern kann man tatsächlich von Konkurrenz sprechen?

Decker: Die Forschung arbeitet daran, Roboter zu bauen, die über kognitive Leistungen, soziales Verhalten, Lernfähigkeit und autonome Handlungsfähigkeit verfügen – Eigenschaften, die wir normalerweise Menschen zuschreiben. In Denksportarten wie Schach, Jeopardy und Go ist der Mensch bereits unterlegen. Die Konkurrenz spielt sich aber vor allem in Teilhandlungen ab: Im Moment reden wir weniger darüber, dass der Mensch an sich durch intelligente Maschinen ersetzt wird, sondern darüber, dass Mensch und Technik zusammenarbeiten. Dabei werden einige Teile der Arbeit an die Technik übertragen, und andere bleiben beim Menschen. Dann gibt es einen Aushandlungsprozess: Wer macht was? Wer ist wofür verantwortlich?

STANDARD: Und hier konkurrieren Mensch und Maschine?

Decker: Die Konkurrenz besteht in der Autonomie. Technische Systeme übernehmen Tätigkeiten, die der Mensch bisher allein gemacht hat. Das beeinflusst unser Verhältnis zur Technik und wie wir damit umgehen. In der Rolle als Akteur, der letztlich verantwortlich bleibt, muss der Mensch sicherstellen, dass die Technik in ihren eigenen Entscheidungen auch vernünftig funktioniert. Die Mensch-Maschine-Interaktion muss so ausgestaltet sein, dass Roboter durchschaubar, vorhersehbar und beeinflussbar bleiben.

STANDARD: Einerseits wollen wir davon profitieren, dass uns Roboter behilflich sind und uns das Leben bequemer machen, andererseits gibt es scheinbar noch wenig Vertrauen in die Systeme – warum ist es so schwierig, die Kontrolle abzugeben?

Decker: Solange der Mensch verantwortlich bleibt, auch wenn jemand zu Schaden kommt, ist das keine triviale Frage. Das wird derzeit insbesondere beim autonomen Fahren diskutiert. Man tritt einerseits Autonomie ab und bleibt andererseits verantwortlich, da kann man sich schon fragen: Warum sollte ich das eigentlich tun? Schon jetzt werden immer häufiger Assistenzsysteme in Fahrzeugen verwendet, so wie Stau- und Parkassistenten. Hier könnte man auch sagen: Der Produzent des Fahrzeugs ist verantwortlich, und ich als Fahrer kann ein Buch lesen.

STANDARD: Welche Hürden sehen Sie für eine breitere Anwendung?

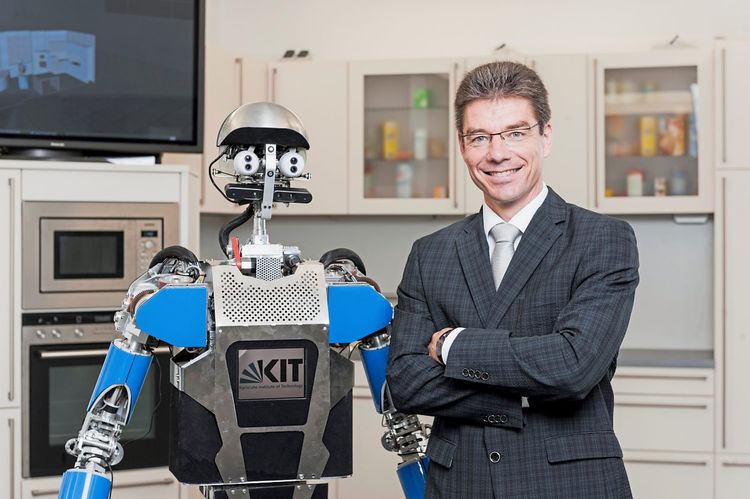

Decker: Eine Hürde ist, dass Technik sich an Situationszusammenhänge anpassen müssen wird. Ich kann mir nicht vorstellen, dass ein Haushaltsroboter vom Werk aus so programmiert ist, dass er in meiner Wohnung sofort agieren kann. Er muss in irgendeiner Form adaptiv programmiert sein, etwas lernen können. In vielen Anwendungsbereichen schwingt das mit, ohne dass das in meiner Wahrnehmung stark genug thematisiert wird. Adaptiv bedeutet, dass sich der Roboter oder die Maschine im Betrieb verändert, um zu verstehen, dass es etwa auf dem Weg in die Küche eine Stufe gibt, oder zu wissen, wo der Kühlschrank ist. Es ist aber auch nicht vorstellbar, dass ich als Nutzer den Roboter programmiere, sodass er sich in meiner Küche zurechtfindet.

STANDARD: Es geht also um die Lernfähigkeit der Maschinen. Wie gut funktioniert das?

Decker: Es gibt unterschiedliche Lernsysteme: Manche orientieren sich weitgehend an einer Wenn-dann-Logik und merken sich, mit welchem "Wenn" sie häufiger zum Ziel kommen. Hier kann ein Experte feststellen, welches "Wenn" zu einem bestimmten "Dann" führte. Die Verantwortung kann also klar zugewiesen werden. Wenn wir die Lernalgorithmen so eingrenzen, ist jedoch auch das Handlungsspektrum stark eingeschränkt. Damit verbauen wir uns eine Menge des technischen Potenzials. Moderne Lernverfahren wie beispielsweise künstliche neuronale Netze haben ein deutlich größeres Lernpotenzial, sie können ähnlich wie wir Menschen lernen. Allerdings kann hier auch ein Experte nicht durch Analyse des Netzes herauslesen, was genau das System gelernt hat. Ja letztlich kann es auch etwas verlernen, was es bereits konnte.

STANDARD: Haben Sie eine Lösung?

Decker: Wir müssen uns überlegen, wie wir die Systeme permanent lernen lassen können und dabei sicherstellen, dass das Gelernte in einer sicheren Art und Weise implementiert wird. Die Systeme könnten etwa Vorschläge machen, was sie gerne lernen würden. Bei künstlichen neuronalen Netzwerken, mit denen etwa das Go-Programm Alpha Go arbeitet, haben wir eben keine Möglichkeit zu überprüfen, wie sie lernen. Das heißt, wir brauchen vertrauenswürdige Prüfinstanzen, die sicherstellen, dass das über einen Zeitraum Gelernte auch so implementiert werden kann, dass ich mich in das Fahrzeug reinsetze und es weiterhin sicher fährt. Dann könnte ein System, das ständig im Hintergrund lernt, was alles im Straßenverkehr vorkommen kann – wie im Sinne des Go-Spielens -, ein besserer Autofahrer werden als der Mensch.

STANDARD: Ein solches autonomes System muss in der Lage sein, vernünftige Entscheidungen zu treffen. Wie moralisch können Maschinen handeln?

Decker: Natürlich könnten wir schon heute Autos so programmieren, dass sie das Tempolimit und den Sicherheitsabstand einhalten. Somit würde die Maschine moralischer handeln als die meisten Menschen. In Bezug auf Terror könnte man Autos bauen, die sich gar nicht in Menschenmengen steuern lassen. Auch wenn das System erst spät erkennt, dass es sich um eine Menschenmenge handelt, könnte es bremsen und die Lenkbewegung verhindern und so zumindest den Schaden minimieren. Da sind wir beim moralischen Programmieren. Damit würde sich die Art und Weise, wie wir fahren, dramatisch verändern. Hier geht es um die Frage, ob die Gesellschaft dem Individuum zumuten kann, dass das Auto nicht mehr macht, was man als Fahrer will. Die Herausforderung wird sein, dass wir uns als Gesellschaft auf Regeln einigen, die wir den Maschinen einprogrammieren.

STANDARD: So wie die Asimow'schen Robotergesetze, bei denen es vor allem darum geht, dass Menschen nicht zu Schaden kommen?

Decker: Man darf nicht vergessen, dass diese Gesetze nicht funktionieren. Isaac Asimow hat schon gesagt, dass relativ schnell Situationen auftauchen, die kein normales Funktionieren erlauben, etwa weil der Roboter an Menschen kommt, die nichts Gutes im Sinn haben und unsinnige Befehle geben. Der Roboter weiß es dann zwar besser, muss aber den Gesetzen folgen.

STANDARD: Braucht es eine Art Turing-Test für autonome Systeme?

Decker: Es geht in die Richtung, der Turing-Test ist ja auf echte Personen ausgerichtet, hier geht es um statistische Fragen. Wir müssen uns die Frage stellen: Welche Benchmark geben wir einer Technik? Muss ein autonomes Fahrzeug so gut fahren wie 100 Absolventen der Fahrschule oder wie 100 gut trainierte Fahrer, die jedes Jahr 20.000 Kilometer fahren? Das Gleiche gilt natürlich auch für den Pflegebereich und viele andere Tätigkeiten. (Karin Krichmayr, 8.7.2017)