Es sind elendslange Gänge. Insgesamt messen sie fast 30 Kilometer in den fünf konzentrischen Ringen des Gebäudes. Meistens sind sie schmucklos und grau. Nur im Ministertrakt und bei den Joint Chiefs of Staff, dem vereinigten Generalstab aller Waffengattungen, signalisieren Mahagoniholz und eine Vitrine mit einer 2003 von der 101. Luftlandebrigade erbeuteten, vergoldeten Kalaschnikow Saddam Husseins, dass sich der Besucher im Nervenzentrum der amerikanischen Militärmacht befindet.

Das Pentagon, Washington, D.C. – der Anfang der 1940er-Jahre erbaute, fünfeckige Koloss am Ufer des Potomac, steht für den alten, den analogen Krieg. Heute allerdings denkt ein guter Teil der 28.000 Menschen, die hier im US-Verteidigungsministerium arbeiten, über "the future of warfare" nach. Die Digitalisierung hat das Kriegshandwerk nicht nur erreicht, sie revolutioniert es gegenwärtig. Und zwar so nachhaltig, wie an der Wende vom 16. zum 17. Jahrhundert die Umstellung von Hieb- und Stichwaffen auf Schusswaffen.

Sensorik, Robotik und KI

Die Treiber dieser Entwicklung sind Sensorik, Robotik und künstliche Intelligenz (KI) – Technologien, die erstmals nicht in den Laboren der Militärs ersonnen werden, sondern zumeist aus dem Zivilsektor kommen, wie Bill Schneider im Gespräch mit dem STANDARD sagt. Er hat als Staatssekretär im US-Außenamt unter Präsident Reagan gedient, vor allem aber war er zwischen 2001 und 2009 Chef des Defense Science Boards, des wichtigsten wissenschaftlichen Beratungsgremiums des amerikanischen Verteidigungsministeriums.

Bild nicht mehr verfügbar.

Die Schlachtfelder der Zukunft werden vom Internet der Dinge und fahrerlosen Vehikeln geprägt sein, sagt Schneider, diese seien teilautonom, werden aber doch noch von menschlicher Hand gesteuert.

Solche im Prinzip wie Drohnen funktionierende Systeme ("das war technisch am einfachsten lösbar") werde es auch zu Lande, im und unter Wasser geben (siehe Wissen unten).

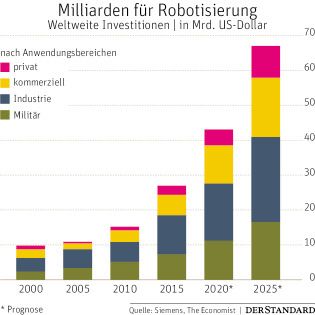

Weil die dafür nötigen technischen Mittel verhältnismäßig günstig und einfach erhältlich sind, hat ein digitales Wettrüsten der Armeen weltweit eingesetzt. Die chinesische Regierung will bis 2030 führend im Sektor künstliche Intelligenz sein.

Derzeit lässt sie für zehn Milliarden Euro Baukosten eine ganze Forschungsstadt dafür errichten. Vom russischen Präsidenten Wladimir Putin ist dieses Zitat überliefert: "Wer in diesem Bereich die Oberhand hat, wird die Welt beherrschen."

Bob Work, Vize-Verteidigungsminister unter Obama und Trump, sagte der "FT" unlängst: "Das Spiel lautet: unsere KI gegen deren KI." will heißen: Die Menschen töten nicht mehr selbst, sie lassen töten – von künstlicher Intelligenz.

Eine Vorahnung dessen, was kommen wird, geben die derzeit bereits funktionierenden Systeme: Israel Aerospace Industries hat die Drohnen Harpy und Harop entwickelt, die als fliegende Bombe kreisen und sich selbstständig auf Luftabwehrstellungen stürzen, sobald sie deren Radarsysteme erfasst haben.

Ende 2016 warfen drei F/A 18 Super Hornets über ihrer Basis in China Lake, Kalifornien, 103 kleine propellerbetriebene und kamerabewehrte Perdix-Drohnen ab, die sich autonom formierten und mit den Jets mitflogen. Die deutsche Bundeswehr unternahm vergangenen Oktober ähnliche Versuche über der Ostsee mit Airbus-Do-DT25-Drohnen als Begleitflugzeugen von Eurofightern.

Bild nicht mehr verfügbar.

Zu Lande experimentieren die US-Marines seit einiger Zeit mit einem von der Defense Advanced Research Projects Agency (Darpa) bei Boston Dynamics in Auftrag gegebenen Robotermuli, der auch unter widrigsten Umständen als Transporter eingesetzt werden soll.

Das Unternehmen aus Massachusetts gilt als weltweit führend im Bereich autonomer Laufroboter und stellt auch Humanoide her, die an den furchteinflößenden T-800 aus den "Terminator"-Filmen der 1980er-Jahre mit Arnold Schwarzenegger erinnern.

In Europa stellte die französische Nexter-Gruppe, die mit der in München ansässigen Panzerschmiede Krauss-Maffei Wegmann verbunden ist und ab 2030 mit den Deutschen einen gemeinsamen europäischen Kampfpanzer bauen soll, im Frühsommer einen Panzerroboter namens Optio vor, der unbemannt und womöglich vollautonom operieren soll.

Clouds und Google-Proteste

Hinter all diesen Systemen stehen enorme Datenmengen, die gesichert, gemanagt und gebraucht werden müssen. Die US-Militärs wollen ihre Teilstreitkräfte in naher Zukunft über eine Cloud mit dem schönen Namen "Jedi" (Joint Enterprise Defense Infrastructure) verbinden, Oracle, Microsoft, IBM und Amazon rittern bereits um den zehn Milliarden Dollar schweren Auftrag. Google zog sich Bloomberg zufolge zuletzt aus dem Rennen zurück. In Europa plant Thales militärische Cloud-Lösungen.

Algorithmische Kriegsführung

Im Pentagon arbeitet zudem ein "Team für algorithmische Kriegsführung", das mit Googles Deep-Learning-Programm Tensor-Flow künstliche neuronale Netze für Waffen baut, die diesen das Erkennen und Qualifizieren von Objekten beibringen sollen. Weil sich firmenintern massiver Widerstand gegen dieses "Project Maven" regte, musste Alphabet-Chef Sundar Pichai im Mai aus der Kooperation aussteigen.

Widerstand kommt auch von Wissenschaftern und Unternehmern: Schon vor drei Jahren riefen etwa der im März verstorbene Stephen Hawking und Tesla-Chef Elon Musk zu einem Verbot dieser Waffen auf, die unweigerlich in den digitalisierten dritten Weltkrieg führen würden. Die NGO Campaign to Stop Killer Robots versucht das Problembewusstsein zu erhöhen, eine UN-Arbeitsgruppe hat erst diese Woche wieder in Genf getagt, um einen rechtlichen Rahmen und bestenfalls ein Verbot für Lethal Autonomous Weapon Systems zu finden.

Bei Chemie- oder Laserwaffen ist das gelungen, bei den Laws stockt der Prozess, weil die in diesem Bereich starken Staaten blockieren. Sie verweisen auch auf die nützlichen Eigenschaften der Roboterwaffen: Präzision, wenig Kollateralschäden, Sicherheit für Soldaten. Pentagon-Chef Jim Mattis sagt, er sei sich nicht sicher, ob in 100 Jahren noch "ein menschliches Element" auf den Schlachtfeldern der Welt zu finden sei. Gerät die Entwicklung außer Kontrolle, könnte das nicht nur auf die Schlachtfelder zutreffen.

Buchtipp: "Legal Killing" und Menschlichkeit

Das Thema ist in der Öffentlichkeit noch kaum bekannt, die Literatur darüber entsprechend bescheiden. Umso wichtiger ist der ebenso breite wie tiefe Einblick, den Markus Reisner in "Robotic Wars" in den digitalisierten Krieg bietet. Der Jurist, Historiker und Oberstleutnant des Bundesheeres gliederte sein Buch in drei Teile: eine Situationsbeschreibung dessen, was derzeit bereits in Konfliktzonen zu beobachten ist (Drone-Killing); die rechtlichen Rahmenbedingungen, in denen bzw. außerhalb derer sich diese Aktionen abspielen (Legal Killing); und in die ethischen Fragen, die diese automatisierte, maschinelle Kriegsführung aufwirft (Just Killing).

Reisner schreibt, dass nicht nur die USA, Frankreich, Italien oder Israel über umfangreiche Drohnenprogramme verfügen, sondern etwa auch der Iran oder Pakistan unbemannte, ferngesteuerte Flugkörper unter anderem zu gezielten Tötungen einsetzen. Selbst Milizen wie der "Islamische Staat" operierten inzwischen mit Kleindrohnen. Das Phänomen ist also bereits weit über eine Testphase hinausgewachsen.

Im rechtlichen Bereich stellt sich für Reisner die Frage, ob die Grundsätze des humanitären Völkerrechts beachtet werden. Ob etwa Angriffe nicht unterschiedslos und unverhältnismäßig geführt werden, gleichzeitig das Gebot der Menschlichkeit eingehalten wird. Er beschreibt auch die schwierigen laufenden Bemühungen der Vereinten Nationen, einen Konsens für die Regulierung dieser Waffentechnologien zu finden – womöglich sogar mit einem Regime, das deren Proliferation regulieren könnte.

Ausführlich widmet sich Reisner auch dem ethischen Aspekt, der sich in einer Grundfrage zusammenfassen lässt: Darf künstliche Intelligenz über Leben und Tod entscheiden? Die Antwort scheint evident: Nein. Der Punkt allerdings ist: Wie lässt sich das sicherstellen in einer völlig durchtechnisierten Welt, in der alles Machbare meistens auch gemacht wird? (Christoph Prantner, 25.11.2018)