In diesen Tagen wird viel Aufmerksamkeit darauf gerichtet, ob und wie künstliche Intelligenz (KI) reguliert werden sollte, um ihre Ethik sicherzustellen. Eine hochrangige Expertengruppe in Brüssel wurde eingesetzt, um sich diesem Thema zu widmen. Sie kurbelt dabei aber leider das für Brüssel übliche "Stakeholder-Karussell" an, in dem Lobbyisten, Meinungsmacher, Industrie und Gesetzgeber darauf bedacht sind, ihre individuellen Interessen durchzusetzen.

Leider ist KI jedoch eine sehr technische Angelegenheit, die sich nicht mit den Laienvorstellungen von "Terminator" und "Blade Runner" gleichsetzen lässt. Zumindest wenn es um technische Standardisierung geht, ist Ethik Neuland. Technologie-Standardisierung beschäftigt sich traditionell mit Datenverarbeitungs- und Übertragungsprotokollen, mit Hardware-Spezifikationen und so weiter. Die Fuzzy-Domäne der Ethik sowie die Kontextsensitivität jeder ethischen Angelegenheit scheint der geradlinigen und homogenen Logik der Technikwelt diametral entgegenzustehen.

Was ist überhaupt Ethik?

Ethik bedeutet, kurz gesagt, das Richtige richtig zu tun und dabei ein guter Mensch zu sein. Mit anderen Worten: Handeln Sie – idealerweise als Vorbild – so, dass Sie oder Ihr Unternehmen zum Wohl der Gesellschaft beitragen? Dass Sie positive Externalitäten schaffen und negative Externalitäten vermeiden? Dass Sie Wohlbefinden in dieser Welt schaffen und das Gegenteil bekämpfen?

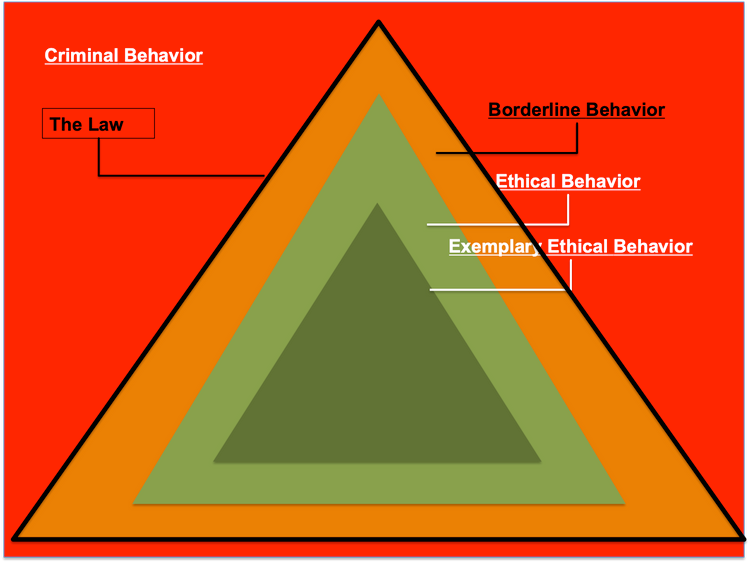

Nicht jeder ist gleichermaßen gut im ethischen Handeln. Die meisten Menschen lernen als Kinder, was es heißt, im grünen Bereich zu bleiben (siehe Abbildung unten). Im Gegensatz zu diesem guten oder ethischen Verhalten gibt es auch schlechtes Verhalten oder das, was das Gesetz als kriminelles Verhalten anerkennt. Märchen nennen es das "Böse". Zwischen diesen beiden Extremen, zwischen gutem und schlechtem Verhalten, zwischen gut und böse, gibt es grenzwertiges Verhalten. Das Gesetz begrenzt wiederum dieses Grenzwertige; es bestimmt, welches grenzwertige Verhalten nicht mehr akzeptabel ist. Es setzt den extremen Punkt, an dem die Rechte der Menschen, der Natur oder der Gesellschaft von Akteuren derart untergraben werden, dass diese zur Gewährleistung der langfristigen Stabilität der Gesellschaft sanktioniert werden sollten.

Aus meiner Sicht kann und sollte jede Technologie, einschließlich KI, so gebaut sein, dass sie ethisches Verhalten bei Menschen und Menschengruppen fördert und keinen Schaden anrichtet. Technologie kann ethisches Verhalten unterstützen. Und vor allem kann sie mit einem ethischen Geist gebaut werden. Letzteres unterstützt das Erstere. Was vor dem technologischen Einsatz nicht ausgeschlossen werden kann, ist, dass grenzüberschreitendes (oder sogar kriminelles) Verhalten durch eine neue Technologie oder durch die Benutzer, die sie verwenden, versehentlich ausgelöst wird. Dies geschah Microsofts Chatbot, der aus Versehen ein Faschist wurde. Technologien müssen daher iterativ verbessert werden, so dass mögliche grenzüberschreitende Effekte in der Folge unterbunden werden können. In dieser Vision gibt es keinen Regulierungsbedarf. Unternehmen und Ingenieure können die Arbeit erledigen und ständig auf das Gute in ihren Artefakten hin arbeiten.

Herausforderung 1: Ethik wird regional unterschiedlich gelebt

Aber hier liegt eine Herausforderung: Ethische Standards variieren zwischen den Weltregionen. Europa hat unterschiedliche Standards in Bezug auf Sicherheit, umweltfreundliche IT, Emissionsniveaus, Datenschutz und so weiter. In Bezug auf den Wert der Freiheit gibt es (leider) völlig verschiedene ethische Standards, wenn wir Europa mit China vergleichen. Es gibt aus westlicher Sicht nicht tolerierbare Differenzen in Bezug auf Geschlechtermodelle, wenn Russland und der Nahe Osten mit Europa oder den USA verglichen werden.

Ethik aber beschäftigt sich immer damit, was für die Gemeinschaft in einer Region gut und richtig ist. Im Gegensatz dazu ist Technologie heute global und sucht Skaleneffekte auf internationalen Märkten. Technische De-facto-Standards, die weltweit eingeführt werden, überschreiten daher oft unwillentlich ethische Grenzen, sobald sie sich auf der ganzen Welt ausbreiten. Die regionalen Gesetzgeber müssen daher dieses grenzüberschreitende Verhalten ausländischer Technologien im Blick haben, um relevante Werte der eigenen Gesellschaft zu schützen. Das ist im Bereich des Datenschutzes geschehen, wo die Datenschutzgrundverordnung (DSGVO) nun den zivilen Wertstandard Europas schützt. Die DSGVO zeigt, dass der Gesetzgeber eine Rolle spielen muss, wenn Technologien grenzüberschreitend sind.

Herausforderung 2: Ethik ist nicht jedermanns Sache

Es gibt noch eine weitere Herausforderung: Leider sind nicht alle Unternehmen Engel. Es gibt zwar "Firmen mit Herz", aber es gibt auch einige, die grenzwertiges Verhalten zum Standard gemacht haben. Sei es, um Kosten zu sparen, als Erster auf einen Markt zu kommen, fragwürdige Geschäftsmodelle zu verfolgen oder neue Dinge auszuprobieren, deren Auswirkungen kaum bekannt sind: Unternehmen können Anreize für ethisch grenzwertige Geschäftspraktiken haben. Beispielsweise kann ein Unternehmen eine KI-Software für die Überwachung oder Grenzkontrolle entwickeln, bei der nicht völlig transparent ist, wie die Softwareempfehlungen zustande kommen, wie die Datenqualität ist und so weiter. Wenn Unternehmen sich in solch einer Situation befinden, spielen sie heute auf zwei Arten ein "Grenzspiel":

Erstens beeinflussen sie die rechtlich-ethische Grenze, indem sie einfach De-facto-Standards in die Welt setzen, ohne Rücksicht auf negative ethische Externalitäten zu nehmen. Beispiele sind Uber und Facebook, die sich mit Kritik über diverse ethische Fragen (wie Hassreden, Datenschutz, vertragliche Vereinbarungen mit Mitarbeitern und so weiter) auseinandersetzen müssen. Zweitens arbeiten Unternehmen aktiv in offiziellen technischen Normungsgremien (wie CEN, ISO, IEEE, dem WWW-Forum et cetera), um sicherzustellen, dass technische Standards mit ihren Geschäftsmodellen und/oder technischen Praktiken vereinbar sind. In beiden Fällen steht für Unternehmen die Ausübung ihres Geschäfts im Vordergrund; mehr als dass sie sich für ethische Externalitäten interessieren.

Was tun?

Wie können Regulierungsbehörden mit diesem Marktmechanismus umgehen? Um das Problem 1 – stillschweigend eingeführte De-facto-Standards – anzugehen, müssten die Regulierungsbehörden Marktzutrittsschranken setzen. Sie können beispielsweise verlangen, dass jede auf den Markt gebrachte neue Technologie einen ethischen Zertifizierungsprozess durchläuft. Europa sollte entschieden darüber nachdenken, was es zulässt und was nicht.

Zur Lösung des Problems 2 – Unternehmen, die auf ordnungsgemäße Normungsprozesse einwirken – müssen die Aufsichtsbehörden den Spielen, die in den offiziellen Normungsgremien gespielt werden, mehr Aufmerksamkeit schenken. Sie müssen sicherstellen, dass dort keine unethischen Grenztechnologien standardisiert werden.

Zusammenfassend gibt es für die Regulierungsbehörden drei Aufgaben, wenn es um Technikethik geht:

1. Die regionalen Gesetzgeber sollten sich immer mit dem ethischen Grenzverhalten ausländischer Technologien befassen, um relevante Werte ihrer Gesellschaft zu schützen.

2. Die Regulierungsbehörden sollten Markteintrittsbarrieren setzen. Sie sollten dafür sorgen, dass neue technische Produkte getestet und ethisch überprüft werden, bevor sie auf dem eigenen Markt gebaut und verkauft werden. Europa sollte klar definieren, was es zulässt und was nicht.

3. Die Aufsichtsbehörden sollten die "Spiele" beobachten, die in Normungsgremien gespielt werden, um sicherzustellen, dass unethische Grenztechnologien durch Normung nicht versehentlich legitimiert werden.

Sind wir in Europa bereit, diesen drei Aufgaben gerecht zu werden? Ich bin mir nicht sicher. Denn eine erste Frage bleibt im Hinblick auf die transregionale politische Architektur Europas im Dunkeln: Wer ist eigentlich "der Regulierer"? Sind es "die Brüsseler", die heute etwa 70 Prozent der Gesetze für die Regionen erlassen? Oder sind es die nationalen Regierungen?

Wer sind die Personen hinter Brüssels Gesetzgebungen?

Nehmen wir an, dass es in Bezug auf Technologie sinnvoll ist, dass die Regulierung in Brüssel stattfindet, damit Europa als Region einen ausreichend großen technologischen Binnenmarkt sichert. Selbst dann sollten wir fragen, wer "Brüssel" eigentlich ist. Wer "in Brüssel"? Wenn wir fragen, wer der Regulierer ist, sollten wir nicht vergessen, dass es hinter dem Schleier der "DG-Bürokratie" (DG steht für "Directorate-General") der Europäischen Kommission tatsächlich um Einzelpersonen geht, über die wir sprechen. Kommissionsbeamte, die für die Regulierung zuständig sind beziehungsweise sich in dieser Rolle sehen.

Und die allererste Frage, wenn es um ethische Technikregulierung geht, sollte sein: Wer sind eigentlich in den Prozessen der EU-Kommission die Personen, die an diesem politischen Gesetzgebungsprozess beteiligt sind? Und zwar sowohl die Kommissäre selbst als auch ihre Ratgeber und involvierten Stakeholder. Verfolgen die involvierten Personen wirklich regionale europäische Interessen? Zum Beispiel: Wenn es eine hochrangige Expertengruppe (HLEG) zur KI-Ethik gibt, lohnt es sich, zu fragen: Wer verwaltet eigentlich den Master der Empfehlungsdokumente dieser Gruppe? Werden die Personen, die den Text kontrollieren, von europäischen Steuerzahlern bezahlt? Oder werden die involvierten Personen von Unternehmen bezahlt? Ja, vielleicht sogar von nichteuropäischen Unternehmen? Um eine Ethik für Europa im Bereich der Technikstandards zu gewährleisten, brauchen wir Transparenz in diesen Fragen.

Welches Menschenbild haben diejenigen, die über KI-Ethik entscheiden?

Nehmen wir an, dass es sich, zum Beispiel bei der HLEG zur KI, um Personen handelt, die von europäischen Steuerzahlern oder NGOs bezahlt und von demokratisch gewählten Verantwortungsträgern unterstützt werden. Eine weitere Frage, die der Kontext der Ethik erfordert, ist: Welches Menschenbild haben die Beteiligten an diesem Prozess; zum Beispiel die Mitglieder der HLEG? Glauben sie an die Würde jedes einzelnen Menschen mit all seinen oder ihren Schwächen? Haben sie einen Sinn für die Verletzbarkeit menschlichen Zusammenlebens, oder denken sie – so wie viele es heutzutage tun –, dass die derzeit analoge Menschheit die letzte suboptimale Generation ihrer Art ist? Haben sie ein realistisches, holistisches Bild vom Menschen, oder glauben sie, dass Menschen Informationsverarbeitungssysteme suboptimaler Natur sind? Kurz: Wem vertrauen wir eigentlich die Regulierung in sensiblen Bereichen wie der Ethik der KI an? Wenn wir uns mit unseren Technologien und insbesondere mit der KI in immer sensiblere ethische und soziale Gefilde begeben, müssen wir diese Frage stellen.

Da Gruppen wie die HLEG für KI Empfehlungen aussprechen und Standards ins Rollen bringen, die Bestandteil unserer Gesetze werden, brauchen wir Gremien wie die frühere Artikel-29-Arbeitsgruppe für den Datenschutz, die (1) anerkannte Fachleute enthält und (2) ethisch anerkannte, integre (weise!) Einzelpersonen, die mit der Beurteilung beauftragt werden können, ob Norm- und Gesetzesvorschläge, die aus solchen Expertengruppen kommen, tatsächlich ethischen Normen entsprechen. Lassen sie uns ein solches Gremium einfach mal als "Hüter der Ethik" bezeichnen.

Hüter der Ethik

Wenn man die Artikel-29-Arbeitsgruppe für den Datenschutz als Vorbild heran zieht, dann handelt es sich hier um Menschen, die nachweislich über einen langen Zeitraum Datenschutzfragen ehrlich vertreten und ihre Beachtung überprüft haben. Sie können also beurteilen, ob so ein Wert wie die Privatsphäre von einem neuen Gesetz oder einer Norm positiv unterstützt oder untergraben wird.

Solche Hüter der Ethik, wie man sie nach Bedarf für einzelne Regulierungsbereiche benennen kann, sollten aus meiner Sicht nicht nur etabliert werden, sondern als ernstzunehmende Machtinstanz in modernen, technologisch durchdrungenen Demokratien geachtet werden. Eine Gruppe, die – rotierend und domänenspezifisch? – befugt ist, Gesetzesvorschläge und Normen abzulehnen. Eine Gruppe, die in das System der Normen und Regulierungen eine neue Art von Gewaltenteilung einfügt, zwischen Lobby-beherrschten Regulierungsbehörden und unternehmensorientierten Normungseinrichtungen einerseits und dem öffentlichen Interesse andererseits.

Diese Gewaltenteilung finden wir heute schon vor; und zwar in Form der höchsten Gerichte. Die höchsten Gerichte entscheiden heute immer häufiger über die Grenze zwischen akzeptablem und inakzeptablem Technologiedesign. Hohe Gerichte kommen jedoch viel zu spät in diesen Prozess. Angesichts der raschen Verbreitung neuer Technologien sollten ethische sensible Entscheidungen unbedingt vor einem Technologieeinsatz getroffen werden, lange bevor De-facto-Standards in der Welt sind. Die gesellschaftlichen Kosten sind viel zu hoch, um ethische Urteile erst dann zu treffen, wenn die Technologie schon verbreitet ist. Jeder Normungsprozess und jedes Gesetz zur Ethik in der Technologie sollte daher von Hütern der Ethik geprüft und abgesegnet werden, bevor sich negative Entwicklungen anbahnen können. Hüter der Ethik sollten die Macht bekommen, das Unerwünschte zu stoppen. (Sarah Spiekermann, 31.1.2019)