Likes und Profilbilder sagen mehr als tausend Worte, wie Michal Kosinski zeigte. Der Wissenschafter entwickelte eine Methode, mit der Algorithmen aus Gesichtern die sexuelle Orientierung auslesen können. Er analysiert mithilfe von neuronalen Netzwerken riesige Datenmengen, um darin Muster zu erkennen. Dafür, dass seine Arbeiten bei Cambridge Analytica zum Einsatz kamen, will er nicht verantwortlich sein.

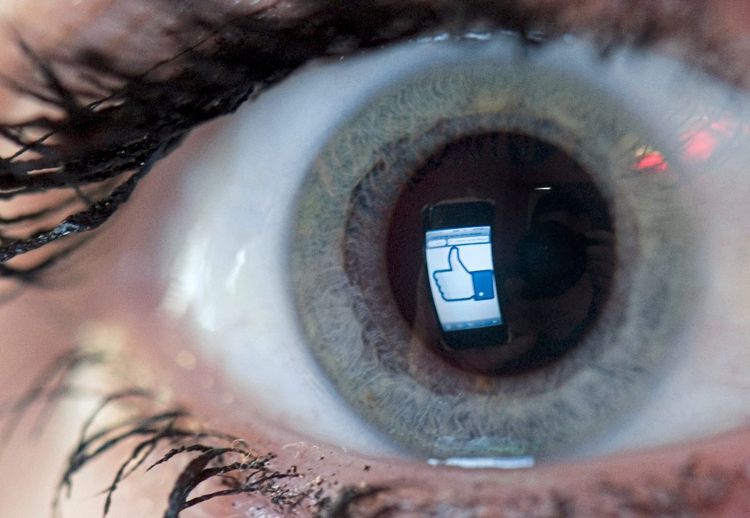

STANDARD: Konsumenten geben bereitwillig vieles via Facebook und Co preis. Ist den Menschen bewusst, was man aus diesen digitalen Spuren auslesen kann? Anders gefragt: Was muss man als Privatperson über dieses Thema wissen?

Kosinski: Wir müssen Bewusstsein dafür schaffen, dass Technologiefirmen Algorithmen einsetzen, um viele weitere Informationen über jeden von uns aus Daten zu extrahieren, die direkt aufgezeichnet werden. Also aus dem digitalen Fußabdruck wie dem geografischen Standort, den das Smartphone aufzeichnet, aus Tweets oder E-Mails, also aus Daten, die an der Oberfläche sichtbar sind.

STANDARD: Zum Beispiel?

Kosinski: Wir nehmen zum Beispiel an, dass wir unsere politischen oder religiösen Ansichten nie online diskutieren und dass diese Informationen privat bleiben. Technologiefirmen können mit ihren Algorithmen aber viel intimere Informationen extrahieren, indem sie sich die anderen Informationen ansehen. Politische und religiöse Ansichten, Persönlichkeit, Intelligenzquotient, sexuelle Orientierung und viele, viele andere Variablen.

STANDARD: Sie sprechen damit eines Ihrer Projekte an, über das heftig diskutiert wurde und das Ihnen den Vorwurf des wissenschaftlichen Rassismus eingetragen hat. Im Kern geht es darum, dass Profilbilder, die wir in sozialen Netzwerken hochladen, genutzt werden können, um unsere sexuelle Orientierung vorauszusagen. Wer profitiert von so einem Projekt?

Kosinski: Ich denke, dass die möglichen Vorteile für Individuen und die Gesellschaft beschränkt sind. Das ist auch der Grund, warum wir offen vor solchen Risiken der Algorithmen warnen müssen.

STANDARD: Als ruchbar wurde, dass die Firma Cambridge Analytica ein von Ihnen entwickeltes Verfahren kopiert hat, um Wähleranalysen zu erstellen – zuletzt für Donald Trump -, haben Sie gesagt, dass Sie die Bombe nicht gebaut haben. Ist es so einfach?

Kosinski: Ich entwickle diese Technologien nicht, das ist ein verbreiteter Irrglaube. Ich beobachte die Tech-Firmen, lese ihre Presseaussendungen über neue Produkte, um zu wissen, was sie tun. Marketingfirmen und Technologieriesen setzen Technologien ein, um psychologische Profile über uns zu erstellen, um unsere intimen Merkmale zu enthüllen und diese Informationen zu nutzen. Dann teste ich diese Methoden, die sie für Marketing oder für politisches Marketing nutzen, wie zum Beispiel Cambridge Analytica, in einem wissenschaftlichen Kontext.

STANDARD: Was ist Ihr Ziel?

Kosinski: Diese Firmen teilen nur widerwillig Informationen über Treffsicherheit und Risiken mit der Öffentlichkeit, mit Forschern und politischen Entscheidungsträgern. Eines meiner Ziele ist es, die Risiken dieser weitverbreiteten Technologien zu verstehen.

STANDARD: Wie können wir sicherstellen, dass Firmen wie Cambridge Analytica unsere Daten nicht missbrauchen?

Kosinski: Eine gute Frage. Ich denke, dass wir diese Risiken minimieren können, indem wir einen offenen Diskurs über die Frage führen, was Algorithmen erreichen können. Dann sollten wir Wege finden, um den Datenmarkt und Technologiefirmen entsprechend zu regulieren. Womit wir uns, glaube ich, anfreunden müssen, ist, dass es unmöglich ist, zurückzukehren zu einer Zeit, in der wir die volle Kontrolle über all unsere Daten hatten.

STANDARD: Müssen wir?

Kosinski: Es wäre möglicherweise einfach, Facebook, Google oder die deutsche oder österreichische Regierung zu regulieren. Aber es gibt ausländische Regierungen, Start-ups, Hacker, die die Regeln brechen könnten, unsere Daten missbrauchen und Algorithmen nutzen, und in unsere Privatsphäre eindringen.

STANDARD: Sie sagten, Donald Trump sagte nicht Danke zu Ihnen. Sind Sie sicher, dass in Ländern wie Russland, die an Ihrer Arbeit interessiert sind, die Informationen die Sie liefern, in guten Händen sind?

Kosinski: Wir können sogar sicher sein, dass die Informationen nicht in den richtigen Händen sind. Ich muss Donald Trump, Wladimir Putin oder der österreichischen Regierung nichts über die Vorteile von psychologischem Profiling basierend auf digitalen Fußabdrücken erzählen. Trump und Putin haben auch Zugang zu diesen Daten und Technologien. Gerade deshalb ist es wichtig, dass wir sicherstellen, dass gutmeinende politische Entscheidungsträger, die Öffentlichkeit und die Wähler sich der Macht dieser Algorithmen bewusst sind. Ohne zu vergessen, dass derselbe Algorithmus, der genutzt werden kann, um unsere intimen psychologischen Charakterzüge zu verstehen und uns zu manipulieren, auch zu unserem Vorteil genützt werden kann. Zum Beispiel, um uns dazu zu bringen mit dem Rauchen aufzuhören, ein gesünderes Leben zu führen, oder durch Früherkennung einer Krankheit rechtzeitig die richtige Behandlung zu bekommen.

STANDARD: Die Tech-Riesen kommen überwiegend aus den USA. Verliert Europa den Anschluss, wenn es zu streng reguliert?

Kosinski: Es ist definitiv möglich, dass striktere Datenschutzregelungen in Europa bedeuten, dass große Tech-Firmen ihre Headquarter und Technologieentwicklung in den USA ansiedeln. Zu strenge Regulierung könnte auch bewirken, dass die Kosten für den Betrieb eines Unternehmens steigen. Damit könnten auch die Preise für Dienstleistungen für Europas Kunden steigen oder sogar der Zugang eingeschränkt werden. (9.4.2019)