Es ist ein inhaltlich trivialer Satz, der für Menschen mit schweren Sprachbehinderungen große Hoffnung birgt: "Die Wahrheit, die du suchst, ist nicht in Büchern verfügbar." Wirklich bedeutsam wird diese Aussage erst durch die Art, auf die sie im Rahmen einer aktuellen Studie gesprochen wurde: mithilfe einer neuen Hirn-Computer-Schnittstelle, die die Worte aus Hirnsignalen von Versuchsteilnehmern am Computer in hörbare Sprache übersetzte.

"Wir konnten zum ersten Mal zeigen, dass es möglich ist, ganze gesprochene Sätze aus der Hirnaktivität eines Menschen zu generieren. Unsere Versuche zeigen, dass das prinzipiell funktioniert", sagt Edward Chang von der University of California in San Francisco. Gemeinsam mit Kollegen hat der Neurologe die Ergebnisse im Fachblatt "Nature" veröffentlicht.

Viele Patienten, die nach schweren neurologischen Erkrankungen, Schlaganfällen oder Unfällen mit Hirnschäden die Sprechfähigkeit verloren haben, sind auf technische Hilfsmittel zur Kommunikation angewiesen. Bisher verfügbare Systeme funktionieren aber zumeist nur eingeschränkt und sind vor allem sehr viel langsamer als gesprochene Sprache. In ihrer aktuellen Studie gingen die Forscher um Chang der Frage nach, wie sich ein Hirn-Computer-Interface zur Spracherzeugung verbessern ließe.

Corticaler Schlüssel

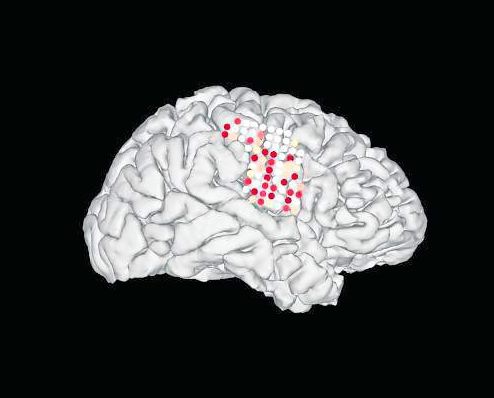

In früheren Versuchen hatten die Wissenschafter herausgefunden, dass sich verständliche Wörter nur schlecht unmittelbar aus neuronalen Signalen ablesen lassen. Daher setzten sie nun einen Zwischenschritt: Sie fokussierten auf die Signale zur Steuerung des Vokaltrakts, der die Laute erzeugt. Genauer gesagt: Sie untersuchten den Bereich des Großhirns, der beim Sprechen für die Koordination von Kiefer, Kehlkopf, Lippen und Zunge zuständig ist.

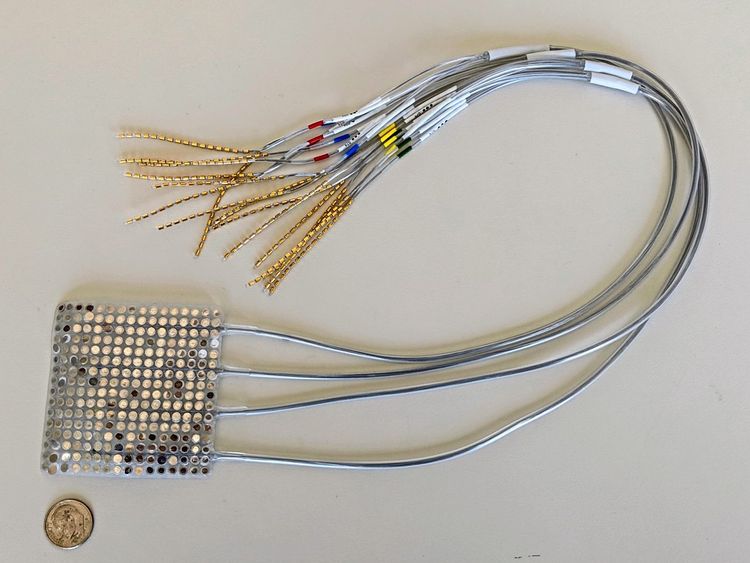

In der aktuellen Studie wurden dann die betreffenden Hirnsignale von fünf Studienteilnehmern aufgenommen, während diese mehrere hundert Sätze laut aussprachen. Die Probanden litten nicht an Sprachverlust, sondern wurden aufgrund anderer Erkrankungen ohnehin mit Elektroden am Gehirn überwacht. Auf Grundlage dieser Daten entwickelten die Wissenschafter ein künstliches neuronales Netzwerk, das die für die jeweiligen Sprechbewegungen verantwortlichen Gehirnsignale zuordnen konnte.

Virtuelle Übersetzung

Im nächsten Schritt schufen die Forscher virtuelle Vokaltrakte, die sich mit den aufgezeichneten Gehirnsignalen der Probanden steuern ließen. Ein Algorithmus übersetzte die "Sprechbewegungen" des Computers schließlich in hörbare Sprache. "Anstatt die Laute also direkt aus den Gehirnsignalen zu entschlüsseln, dekodieren wir die Bewegungen, die sie erzeugen", sagt Chang. Auf diese Weise generierte Sätze waren durchwegs gut verständlich. Zudem fiel auf, dass die neuronalen Codes für Sprechbewegungen bei den fünf untersuchten Teilnehmern große Überschneidungen aufwiesen.

In einem weiteren Versuch wurden zunächst ebenfalls die Hirnsignale eines Probanden während des Sprechens einiger Sätze aufgezeichnet. Dann musste er die Sprechbewegungen wiederholen, nun aber, ohne Laute von sich zu geben. Die Hirnsignale, die dabei entstanden, ließen sich ebenfalls in hörbare Sprache umwandeln – wenngleich das Ergebnis schwerer verständlich war.

Weitere Forschung nötig

Die Forscher räumen ein, dass noch Verbesserungen nötig sind, ehe das System unvorhergesehene und nicht zuvor laut ausgesprochene Sätze aus Hirnsignalen verlässlich dekodieren kann. Sie zeigen sich aber zuversichtlich, dass Gehirn-Computer-Schnittstellen für Menschen mit Sprachverlust nach diesem Prinzip in Zukunft funktionieren werden.

Wie könnte das in der Praxis aussehen? Müssten sich Betroffene dann die Bewegungen vorstellen, die sie beim Sprechen eines Satzes machen würden? Nein, sagt Chang: "Sie müssten nur versuchen zu sprechen. Das Gehirn übersetzt Gedanken, die man auszusprechen versucht, sofort in Bewegungen des Vokaltrakts" – und die ließen sich eben am Computer rückübersetzen.

Die Neuroingenieure Chethan Pandarinath und Yahia Ali würdigen die Fortschritte in einem Begleitkommentar in "Nature" als "überzeugend", verweisen aber auf "viele offene Herausforderungen" auf dem Weg zur ausgereiften Anwendung. (David Rennert, 25.4.2019)