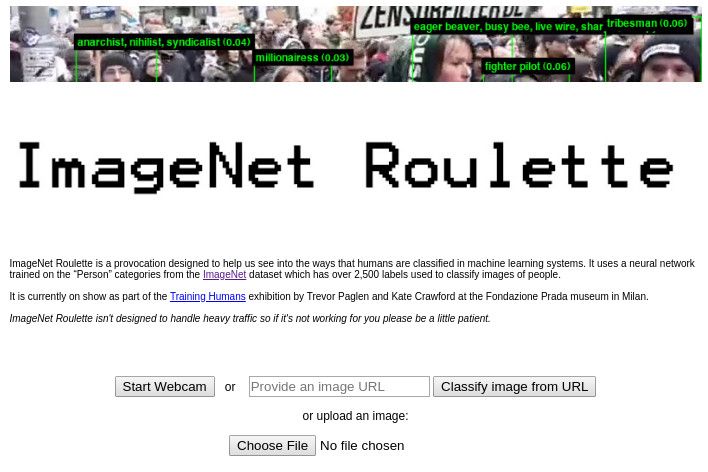

Imagenet Roulette.

Ob das, was heute als künstliche Intelligenz bezeichnet wird, auch diesen Namen verdient, ist eine selbst unter Forschern umstrittene Frage. Klar ist aber, dass Maschinenlernen mithilfe von neuronalen Netzwerken durchaus spannende Einsatzmöglichkeiten bietet. Aber auch welche, die durchaus problematisch sein können. Wie problematisch, zeigt nun ein neues Kunstprojekt von Trevor Paglen, das in Kooperation mit der KI-Forscherin Kate Crawford entstanden ist.

Roulette

Bei "Imagenet Roulette" können Nutzer eigene Bilder hochladen, die dann von der KI mit einem Substantiv versehen wird. Der Begriff wird mithilfe eines neuronalen Netzwerks ausgesucht, das wiederum mithilfe der Forschungsdatenbank Imagenet auf Gesichter trainiert wurde. Das Ergebnis kommt angesichts früherer Untersuchungen in diesem Bereich nicht sonderlich überraschend: Die KI reproduziert eifrig Vorurteile.

So zeigt ein Testlauf etwa, dass Männer mit dunkler Hautfarbe auffällig oft als "Waisenkinder" klassifiziert werden. Auch der Begriff "rape suspect" (also: einer Vergewaltigung Verdächtiger) kommt wesentlich mehr als bei Männern mit heller Hautfarbe vor. Bei dunkelhäutigen Frauen fällt wiederum regelmäßig der Begriff "homegirl", was sich als weibliches Mitglied einer Gang übersetzen lässt.

Zielsetzung

Wie das neuronale Netz zu exakt diesen Begriffen kommt, ist dabei nicht klar. Der Grund für die Vorurteile ist hingegen kein Geheimnis: KI-Forscher haben immer wieder gezeigt, dass neuronale Netze Vorurteile des Materials, mit dem sie trainiert wurden, reproduzieren. Genau diesen Umstand wollten Paglen und Crawford mit Image Net Roulette denn auch offenbaren und dabei auch gleich sichtbar machen, welche Klassifizierungen hier so vorgenommen werden – immerhin sind diese Informationen den Nutzern meist nicht zugänglich. (red, 17.9.2019)