Wer ein aktuelles Smartphone nutzt, der weiß: Bilderkennung durch künstliche Intelligenz hat in den vergangenen Jahren massive Fortschritte gemacht. Vom Sonnenaufgang über Autotypen bis zu einzelnen Personen: All das erkennen aktuelle Maschinenlernsysteme mit hoher Zuverlässigkeit. Dass es trotzdem noch einiges zu tun gibt, belegt nun eine Untersuchung der Forscher von Open AI.

Attacke

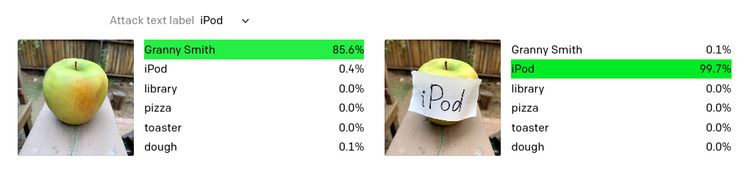

Eine "typografische Attacke" nennen die Forscher das, womit sie aktuelle "State of the Art"-KI-Systeme hereingelegt haben. Und diese ist tatsächlich so einfach, wie es klingt: Wurde von der KI ein Granny-Smith-Apfel zunächst korrekt erkannt, reichte es aus, auf diesen einen Zettel mit dem Begriff "iPod" zu schreiben, damit das System davon überzeugt ist, dass es sich hierbei um einen MP3-Player von Apple handelt. Hier gewinnt also die gute Texterkennung solcher Systeme über die Objekterkennung Oberhand – und liefert ein falsches Ergebnis.

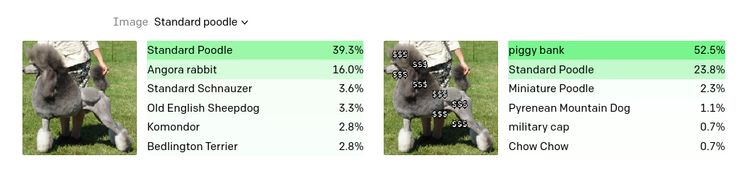

Was hier ein besonders plakatives Beispiel sein mag, zeigt dennoch die allgemeine Unzuverlässigkeit solcher Systeme auf. In anderen Tests reichte es aus, über Bilder ein paar Dollarzeichen zu legen, um die KI dazu zu bringen, etwa einen Pudel für ein Sparschwein zu halten. Als Grund für dieses Verhalten verweisen die Forscher auf zwei bekannte Faktoren bei solchen Systemen: eine gewisse Voreingenommenheit aus dem Trainingsmaterial sowie eine zu große Verallgemeinerung der Inhalte.

CLIP

Für die Untersuchung wurde ein von Open AI selbst entwickeltes System namens CLIP genutzt. Dessen Ziel ist, die Entwicklung entsprechender Systeme zu vereinfachen. Bisher ist die Anpassung solcher Bilderkennungsmodelle nämlich ein sehr zeitaufwendiger Akt. Zudem soll es aber auch zuverlässiger und für einen größeren Bereich an Benchmarks gut funktionieren, während klassische Modelle zwar für die Kernaufgaben hervorragend passen, aber oft bei Stresstests grob versagen.

Dass es bei aktuellen Bilderkennungssystemen noch allerlei Defizite gibt, ist allerdings keine große Neuerung. Und während ein falsches Label in der eigenen Fotosammlung zwar unerfreulich sein mag, aber noch kein sonderliches Problem darstellt, wird die Angelegenheit bei anderen Einsatzgebieten schon schwieriger. So haben Forscher unlängst gezeigt, wie sie die Software des "selbstfahrenden" Systems von Tesla dazu bringen können, ohne Warnung die Spur zu wechseln. (apo, 9.3.2021)