Künstliche Intelligenz ist nicht neutral. Sie trägt die Weltsichten ihrer Entwickler in sich. Das kann auch zu Problemen führen.

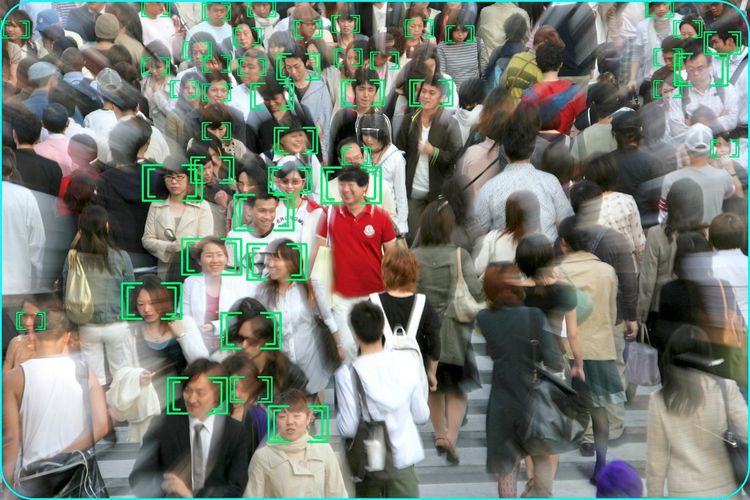

Einschätzungen zu Kreditwerbern bei Banken, die Bewertung von Job-Bewerbungen oder auch nur die automatische Erkennung von Gesichtern auf Fotos: Mit der Zunahme der Einsatzbereiche von künstlicher Intelligenz (KI) werden auch ihre Probleme greifbarer.

Denn die Systeme sind letztendlich nicht besser als ihre menschlichen Entwickler, sondern verinnerlichen deren vorurteilsbehafteten Blick auf die Welt. Bankensysteme benachteiligen deshalb vielleicht Menschen, die in "schlechten Bezirken" wohnen, die Human-Resources-KI unterliegt einem Gender-Bias, und die Bilderkennung kann Gesichter weißer Menschen besser identifizieren als jene von Schwarzen.

Besonders schwerwiegend können die Folgen im Polizei- und Justizwesen ausfallen. Immerhin entscheiden sie in manchen Gesellschaften bereits, wer einer Straftat verdächtigt wird oder wie hoch das Strafmaß eines Verurteilten bemessen wird.

Konsequenzen für die KI-Anwender

Die Forschung hat sich in vielerlei Aspekten damit beschäftigt, wie die ungerechte Schlagseite dieser Systeme entsteht und welche Auswirkungen die resultierenden Entscheidungen für Betroffene haben können. Ein Bereich, der in den Untersuchungen noch unterbelichtet ist, liegt in den Konsequenzen des KI-Einsatzes für die Anwender selbst – also für jene Mitarbeiter und Mitarbeiterinnen in Banken, Personalabteilungen und anderen Organisationen, die die algorithmischen Entscheidungshilfen einsetzen.

Mit diesen Aspekten haben sich Lukas Daniel Klausner vom Institut für IT-Sicherheitsforschung der FH St. Pölten und Angelika Adensamer, Juristin am Vienna Centre for Societal Security in einem von der Arbeiterkammer Wien unterstützten Projekt befasst. Zu den Ergebnissen gehören das Onlinetool Vera, das Kompetenzkonflikte und Verantwortungslücken beim KI-Einsatz aufzeigen soll, sowie ein Leitfaden für Manager und Betriebsräte, der bei der Einbettung der Technologien in die Organisationsstrukturen helfen soll.

Vorschläge nachprüfen

"In einem leistungsorientierten Umfeld sind die KI-Systeme dafür da, den Output zu erhöhen und die Effizienz zu steigern. Dank ihnen sollen Mitarbeiterinnen oder Mitarbeiter also mehr Entscheidungen in derselben Zeitspanne treffen können", sagt Klausner. "Doch es ist fraglich, ob die Zeit dann noch reicht, die Vorschläge des Assistenzsystems tatsächlich nachzuprüfen." Es besteht die Gefahr, dass das gesteigerte Arbeitspensum dazu führt, dass die Systemeinschätzungen unreflektiert übernommen werden.

Ob ein sinnvoller Einsatz von KI-Systemen gelingt, hängt für Klausner von den konkreten Rahmenbedingungen ab. "Eines der größten Probleme ist, dass die Mitarbeiterinnen und Mitarbeiter nicht ausreichend geschult sind und ihnen die Fähigkeit fehlt, die Arbeit des Algorithmus zu verstehen und kritisch zu hinterfragen", sagt der IT-Experte.

Gleichzeitig stellen die Technologien selbst die erforderliche Nachvollziehbarkeit oft nicht bereit – gerade im Bereich des maschinellen Lernens, in dem der individuelle Lösungsweg zur Blackbox wird.

Klare Verantwortlichkeit

Gefahren in der KI-Anwendung können zudem in der Gestaltung der unternehmerischen Strukturen liegen. "Es ist ratsam, vor Einsatz eines Systems die bestehenden Verantwortlichkeiten genau zu dokumentieren – auch um zu erkennen, wie die Technologien diese verändern", erklärt der IT-Experte. Es müsse etwa verhindert werden, dass die Verantwortlichkeit auf zu viele Köpfe verteilt wird – sodass sich letztendlich niemand mehr wirklich zuständig fühlt.

"Von der Perspektive der Organisationsentwicklung muss klar definiert sein, welche Ziele mit der Einführung der KI-Systeme verfolgt werden – und ob es Zielkonflikte beispielsweise zwischen Effizienzsteigerung und Qualitätssicherung gibt", sagt Klausner.

Dass ein individuelles menschliches Vorurteil als Teil eines Arbeitsprozesses durchaus stärker ausgeprägt sein kann als ein algorithmischer Bias, ist für Klausner kein Argument für die KI: "Die Entscheidungen, die ein vorurteilsbeladener Mitarbeitender trifft, haben Auswirkungen auf eine viel kleinere Gruppe von Menschen als jene Entscheidungen, die ein System trifft, dem ein Vorurteil einprogrammiert ist und das hunderte Personen nutzen." (Alois Pumhösel, 1.6.2021)