Als Mark Zuckerberg sein Unternehmen Facebook in Meta umtaufen ließ, rief er das "Metaverse" als neue, große Vision aus. Vorbei die Zeiten verhältnismäßig simpler Social Networks und Kommunikations-Apps. In einer neuen, reichhaltigeren, interaktiveren Form des Internets – angetrieben von Augmented Reality, Virtual Reality und künstlicher Intelligenz – sieht er die digitale Zukunft.

Abseits von Spielen ist das VR-Erlebnis bislang aber ernüchternd. Das zu ändern soll auch eine der wichtigsten Aufgaben des drittgenannten Bausteins werden. KI soll der Kitt werden, der das Metaverse zusammenhält. Indem es Nutzer unterstützt und zahlreiche Anwendungen und Produkte ermöglicht, die es heute noch nicht gibt. Das untermauert Meta nun mit der Vorstellung des "AI Research Supercluster" (RSC), eines auf Forschung und Entwicklung im KI-Bereich getrimmten Supercomputers, auf dem sogar "Crysis" laufen dürfte.

Große Pläne

Mit diesem möchte man hoch hinaus. Der RSC soll schon jetzt zu den schnellsten KI-Supercomputern seiner Art gehören. Und Meta gibt sich zuversichtlich, dass er im Vollausbau endgültig zur Nummer eins in Sachen Performance aufrücken wird. Bereits Mitte dieses Jahres soll es so weit sein. In Zukunft sollen darauf fortgeschrittene KI-Modelle trainiert werden können, beispielsweise für Systeme, die gesprochene Kommunikation in Echtzeit übersetzen sollen. Oder zur Identifizierung problematischer Social-Media-Inhalte, bei der sich gerade das Netzwerk Facebook in den letzten Jahren immer wieder grobe Fehler geleistet hat.

Es ist nicht der erste Rechencluster, den Meta für seine Forschungen aufgestellt hat. 2017 errichtete man ein System aus 22.000 Nvidia-Grafikeinheiten des Typs V100 mit Tensor-Cores, die sich besonders für KI-Training eignen. Dieser Cluster erledigt rund 35.000 Trainingsaufträge pro Tag. Sein Nachfolger ist gemäß ersten Tests bis zu 20-mal schneller bei Computer-Vision-Aufgaben und dreimal flotter beim Trainieren umfangreicher Sprachmodelle.

2020 entschloss man sich schließlich zum Aufbau einer neuen Infrastruktur, die in der Lage sein sollte, Modelle mit einer Billion Parameter und einem Datensatz von bis zu einem Exabyte an Größe trainieren zu können. Die Größe, so Meta, entspricht dem Äquivalent von 36.000 Jahren an hochauflösenden Videoinhalten.

16.000 Grafikeinheiten im Vollausbau

Während man auf dem Vorgänger-Cluster nur mit öffentlich verfügbaren und Open-Source-Datensätzen gearbeitet hat, soll am RSC mit Realdaten aus Metas Produktivsystemen hantiert werden. Auch daraus verspricht man sich große Fortschritte bei der Bekämpfung unerwünschter Inhalte wie auch bei der Optimierung des Nutzungserlebnisses der eigenen Apps.

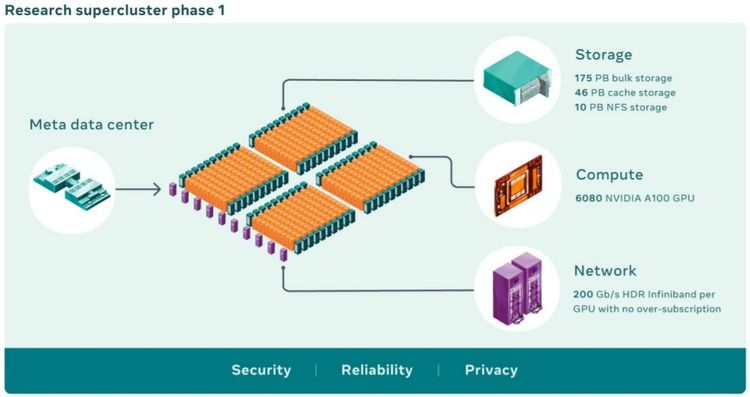

Zum Start besteht der RSC aus 760 Rechnern des Typs Nvidia DGX A100, die insgesamt 6.080 A100-Grafikeinheiten mitbringen, die ihrerseits wesentlich stärker sind, als die bisher genutzten V100. Untereinander angebunden sind diese mit Nvidias Infiniband-Technologie, die eine Übertragungsrate von bis zu 200 Gigabit pro Sekunde (rund 25 Gigabyte pro Sekunde) erlaubt. Dazu kommen 175 Petabyte an Primärspeicher (PureStorage FlashArray) und 46 Petabyte an Cache-Speicher.

Das ist allerdings erst der Anfang. In wenigen Monaten sollen 16.000 GPUs werken. Dazu kommt ein Caching- und Speichersystem, das bis zu 16 Terabyte pro Sekunde an Trainingsdaten ins System schaufeln kann und dessen Kapazität künftig auf ein Exabyte hochskaliert werden soll. Zudem entwickelte man ein Speichersystem, das bereits eine Vorverarbeitung von Trainingsdatensätzen vornimmt und bei der Speicherung darauf achtet, den überregionalen Datenverkehr zwischen den Meta-Rechenzentren möglichst zu minimieren. Angesichts der Pandemie hat man den RSC zudem darauf ausgelegt, dass die Forscher ihn auch aus der Ferne nutzen können.

Sicherheit und Performance

Dieser Aspekt und die Verwendung eigener Datensets wirft natürlich die Frage nach der Datensicherheit auf. Man habe das System "von Anfang an auf Datenschutz und Sicherheit ausgelegt", verspricht Meta. Der Cluster sei isoliert vom "weiteren Internet", es gibt keine direkten Verbindungen hinein oder hinaus.

Daten können nur über Metas Rechenzentren von und zum Cluster fließen. Diese sind zudem vollständig Ende zu Ende verschlüsselt, und Trainingsdaten werden erst unmittelbar vor ihrem Einsatz entschlüsselt. Doch bevor sie überhaupt ins System geschickt werden, ist ein Privacy-Review vorgesehen, bei dem die korrekte Anonymisierung sichergestellt werden soll.

Last but not least liefert Meta dann doch noch Zahlen zur Performance, wenn auch nur über die erwartete Leistung im Vollausbau. Wenn im RSC künftig 16.000 GPUs laufen, soll er als weltweit schnellster Supercomputer für KI-Aufgaben eine Mixed-Precision-Compute-Leistung von fünf Exaflops erreichen.

Ein direkter Vergleich mit anderen Systemen ist schwierig. Am ehesten bieten sich die öffentlich verfügbaren Resultate des HPL-AI-Benchmarks an. Hier führt derzeit der Supercomputer Fugaku am Riken-Center im japanischen Kobe. Er erreicht bei KI-spezifischen Rechenlasten eine Performance von zwei Exaflops und führt auch die zuletzt im November kompilierte Rangliste der schnellsten konventionellen Supercomputer an. (gpi, 24.1.2022)