Kaum ein Tech-Bereich hat in den vergangenen Jahren so viele Fortschritte gemacht wie künstliche Intelligenz (KI). 1996 galt es als Meilenstein, als der an eine umfangreiche Zugdatenbank gekoppelte Computer "Deep Blue" den russischen Schachweltmeister Garri Kasparow in die Schranken weisen konnte. Mittlerweile ist das "Spiel der Könige" längst keine Herausforderung mehr.

Heute schlägt der Computer auch Profis in wesentlich komplexeren Spielen wie "Go", ohne dafür alle möglichen Züge kennen zu müssen. Stattdessen können Systeme wie "AlphaGo" menschliche Partien analysieren und in Matches gegen sich selbst Strategien erlernen. Ihre Weiterentwicklungen werden künftig sogar in der Lage sein, die Regeln von Spielen durch bloßes "Zusehen" zu erlernen.

Von der Sprachassistentin zur Künstlerin

Aber auch im Alltag ist der Fortschritt spürbar. Sprachassistenten verstehen und beantworten unsere Fragen und Befehle. Am Handy können wir Text im Visier der Kamera in Echtzeit mit einer Übersetzung überlagern lassen. Moderne Bildbearbeitungssoftware kann Personen, Tiere und Objekte erkennen und diese – oder ihren Hintergrund – verschwinden lassen. Und KI ist auch in der Lage, Kunst zu erzeugen.

Eine der beeindruckendsten Entwicklungen sind dabei Systeme, die man mit einer Beschreibung füttern kann, aus der dann ein Bild generiert wird. Hier spielen zahlreiche Mechanismen zusammen. Die KI muss den eingegebenen Text analysieren und versuchen, ihn nicht nur wörtlich, sondern auch seinen Kontext zu verstehen. Die so zerlegte Eingabe muss anschließend visuell wieder zusammengebaut werden. Selbst wenn der Auftrag nur aus einem kurzen Satz besteht, ist das eine sehr komplexe Aufgabe.

Welche Möglichkeiten hier offen stehen, bewies Nvidia mit seinem neuronalen Netzwerk StyleGAN und der Website "This Person Does Not Exist". Hier ließ man die KI anhand abertausender Fotos lernen, wie sich menschliche Gesichter zusammen setzen. Das System lernte so, dass Elemente wie Augen, Nase und Mund ein Antlitz prägen und wo sie sich befinden können. Ebenso vermochte es den Zusammenhang zwischen (eher) männlichen und (eher) weiblichen Zügen herzustellen. Das Resultat sind zufällig erzeugte "Fotos", die oft nur durch sehr genaues Hinsehen als unecht identifizierbar sind.

Ein Experiment mit "Midjourney"

Für eine KI, die Bilder nach willkürlicher Beschreibung erzeugt, ist die Herausforderung ungleich größer, da sie nicht auf bestimmte Merkmale trainiert werden kann. Dennoch lassen sich damit teils beeindruckende, jedenfalls aber sehr spannende Ergebnisse erzielen. Eines dieser Systeme nennt sich "Midjourney". DER STANDARD nutzte die Gelegenheit, damit zu experimentieren.

Als österreichisches Medium bietet sich als Nagelprobe natürlich ein Schnitzeltest an. Nutzer können die KI über einen Discord-Chat mit Eingaben füttern. Mit dem Kommando "/imagine" initiiert man die Angabe einer englischsprachigen Bildbeschreibung, gefolgt von etwaigen technischen Vorgaben, wie etwa einem bestimmten Seitenverhältnis des Werks. Die Erzeugung des Bildes lässt sich live mitverfolgen. Standardmäßig spuckt Midjourney vier Versionen eines Ergebnisses aus. Diese kann man entweder einzeln in größerer Form errechnen lassen oder als Grundlage für weitere Varianten heranziehen.

Und was soll man sagen? Den Schnitzeltest besteht die KI meisterhaft. Einziges Manko: Auf einem Bild ist der Teller leer und auf einem weiteren das Schnitzel offenbar schon weitestgehend konsumiert. Nichtsdestotrotz war Midjourney offenkundig in der Lage, ein Wiener Schnitzel von anderen Schnitzelvariationen zu unterscheiden und glaubwürdig auf einem Teller zu platzieren. Die ursprüngliche Eingabe ist übrigens jeweils in der Bildunterschrift vermerkt.

Man kann in den Angaben aber auch durchaus konkreter und detaillierter werden sowie Wünsche zur grafischen Umsetzung platzieren. Was passiert, wenn man sie "schöne" lumineszente Quallen in der Tiefsee zeichnen lässt? Auch diesen Auftrag erfüllt sie gut. Die Quallen sind weitestgehend als solche zu erkennen, und die gewünschten Lichteffekte wurden berücksichtigt.

Bias und Zukunftsvisionen

Aber was ist eigentlich Schönheit? Diese Frage ermöglicht es auch, einen etwaigen Bias im Datenmaterial aufzuspüren, anhand dessen die KI gelernt hat. Lassen wir sie also die schönste Frau und den schönsten Mann der Welt erzeugen.

Beide Ergebnisse zeigen zu einem gewissen Grad Merkmale gängiger Beauty-Stereotype (zum Beispiel Schlankheit, Muskeln, hohe Wangenknochen). Ein möglicher Marker für ein Ungleichgewicht in der Datenlage ist zudem, dass die erzeugten Personen in allen Fällen hellhäutig sind.

Die KI ist aber auch in der Lage, abstraktere Anweisungen zu verarbeiten, bei der sie sich mehr auf ihren Datenschatz und Kontextualisierungsfertigkeiten stützen muss, denn auf die Beschreibung. Fragen wir sie also, wie eine Welt aussehen könnte, wenn der emissionsbedingte Anstieg der globalen Durchschnittstemperatur nicht unter zwei Grad gehalten wird.

Das Ergebnis ist eine wenig detaillierte, aber umso düsterere Zukunftsvision. Dass auf zwei Bildern ein Planet groß am Firmament zu erkennen ist, könnte ein Hinweis darauf sein, dass das Lernmaterial sich auch an dystopischen Vorlagen bedient hat, in der die Rettung der Menschheit den Abschied von der Erde bedingt. Eine weitere Interpretationsmöglichkeit ist auch, dass die KI den Begriff "world" weiter ausgelegt und nicht ausschließlich auf unseren Planeten bezogen hat.

"Style Transfer"

Wie sieht es mit (pop-)kulturellen Bezügen aus? Die Eingabe des gängigen Leitspruchs von Cthulhu-Kultisten oder etwa die Transformation von Mr. Spock in einen Wrestler zeigen Stärken wie auch Schwächen auf. Mit der Abbildung des Cthulhu-Mythos und des damit verbundenen Tentakelwesens tut sich Midjourney um einiges leichter als bei der Formung von Körpern und Gliedmaßen.

Das ist ein wiederkehrendes Muster. Es schwächelt nicht nur bei der Darstellung von Händen. Insbesondere bei Tieren generiert das System öfters drei oder fünf Beine, wo eigentlich vier sein sollten.

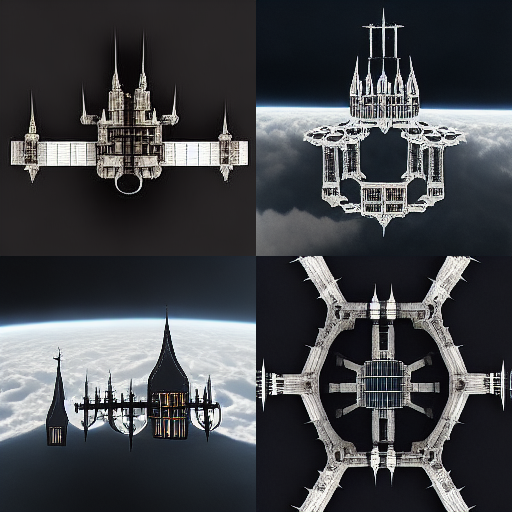

Was es hingegen sehr gut beherrscht, ist eine Technik namens "Style Transfer". Sie ist in der Lage, "gestalterische" Merkmale von Bildern zu erkennen und auf andere zu übertragen – und das universell. Die KI kann nicht nur den Stil verschiedener Maler oder zeichnerischer Genres kopieren, sondern auch nicht künstlerische Merkmale, etwa von technischen Zeichnungen oder Fotos eines bestimmten Jahrzehnts, imitieren.

Hier demonstriert anhand einer "glücklichen" Szene in der Art des für seine düsteren Arbeiten bekannten Alfred Kubin und einer Planzeichnung des Brandenburger Tors.

Auch hier ist mehr Abstraktion möglich. Die künstliche Intelligenz ist auch in der Lage, sich an der "typischen" Darstellung von Filmen zu orientieren oder eine Zeichnung zu erstellen, als hätte sie vierjähriges Kind gemalt. Zu sehen hier anhand von Tieren auf einem Feld sowie einer römischen Plaza-Szene im Stile von "The Matrix".

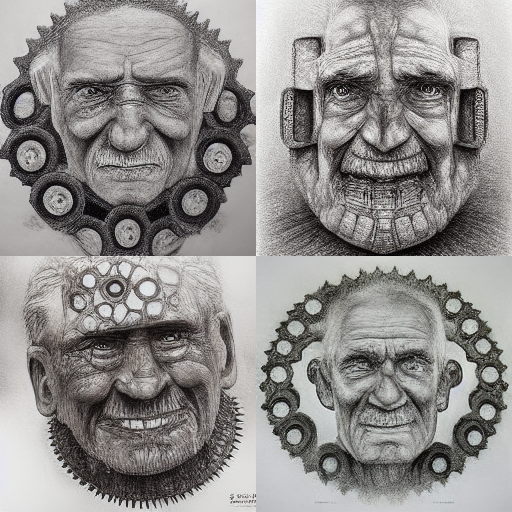

Das lässt sich natürlich auch auf die Spitze treiben, indem man detaillierte Motiv- und Stilangaben vermischt. Sehenswert sind hier etwa das Gesicht eines alten, faltigen und glatzköpfigen Mannes aus Stein, umgesetzt als "2D-Kunst". Oder – als persönliches Highlight des Autors – zwei französische Bäcker, die sich mit Baguettes ein Duell in "Star Wars"-Ästhetik liefern.

An letzterem Ergebnis ist zu sehen, dass sich die KI immer wieder damit plagt, die kontextuell richtigen Verknüpfungen in der Beschreibung zu finden. Das etwas bizarre Ergebnis ist dennoch sehenswert.

Nicht umgehen kann Midjourney allerdings mit Text. Immer, wenn irgendwo Schriftzüge auftauchen, sind diese zwar als solche erkennbar, aber abgeschnitten und "verzerrt", so wie etwa beim Versuch, eine DER STANDARD-Titelseite, wie sie in den 1930ern aussehen hätte können, zu generieren. Oft sehr überzeugend schlägt sich das System dafür, wenn es darum geht, Landschaften zu erschaffen.

Die Aufgabe, einen nebligen, moosbewachsenen Wald im Morgenlicht abzubilden, meistert sie mit Bravour. Dabei wird auch deutlich, dass selbst Details wie der Einfallswinkel des Lichtes, Schattenwurf und Reflexionen berücksichtigt werden.

Großes Potenzial benötigt große Vorsicht

Was kann man aus den Fertigkeiten lernen, die Midjourney mitbringt? (Weitere Bildbeispiele sind dem Text beigestellt.) Mitnehmen kann man, dass in KI-Tools wie diesem riesiges kreatives Potenzial steckt. Für fehlerfreie, glaubwürdige Kunstwerke reicht es oft noch nicht, doch wer sich inspirieren lassen möchte, kann mit einer kurzen Eingabe spannende Vorlagen für eigene Werke erschaffen lassen. Der Fantasie sind hier keine Grenzen gesetzt, sie wird einzig und allein vom Kontextverständnis der KI limitiert.

Eine detailliertere Erklärung dazu, wie diese Systeme funktionieren und wie ihre Entwicklung bisher verlaufen ist, liefert übrigens der Youtube-Kanal Vox in einer kurzen Dokumentation.

Dass Midjourney (oder auch andere KIs wie Dall-E der OpenAI Foundation) noch viel Luft nach oben haben, sieht man, wenn ein Konzern wie Google seine Ressourcen dafür mobilisiert. Unter dem Namen "Imagen" verspricht man fotorealistische Ergebnisse. Und die ausgewählten Ergebnisse auf der Projektseite untermauern dies auch.

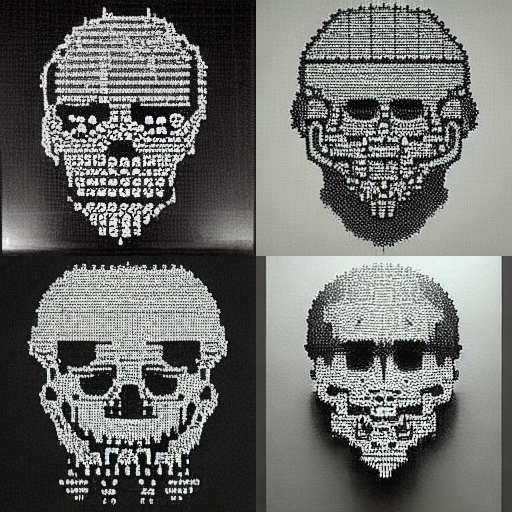

Öffentlich zugänglich will der IT-Riese diese Technologie allerdings nicht machen. Aus gutem Grund. In den letzten Jahren wurde immer wieder über Deepfakes diskutiert. Darunter versteht man die KI-gestützte Manipulation von Audio-, Video- und Bildinhalten. Auch hier steckt freilich künstlerisches Potenzial drin, aber eben auch eine nicht zu unterschätzende Missbrauchsgefahr.

So lassen sich etwa Politikern Aussagen unterjubeln, die sie nie getätigt haben, oder die Gesichter von beliebigen Frauen werden in Pornoclips montiert, oder die KI denkt sich einen nackten Körper für sie aus ("Deepnudes"). Mancherorts beschäftigt das Thema auch schon die Politik. In Virginia wurde 2019 ein Verbot von Deepfake-Pornografie und Deepnudes beschlossen. Kalifornien folgte und erweiterte dies auch auf solche Fälschungen in Wahlkämpfen. (Georg Pichler, 12.6.2022)