Schulkinder lernen zu multiplizieren und zu dividieren, ohne den daneben liegenden Taschenrechner verwenden zu dürfen – obwohl dieser das Rechnen viel schneller und viel verlässlicher erledigen könnte. Unter dieser pädagogischen Erfahrung hatte gewiss nicht nur der Autor dieses Textes zu leiden. Die Begründung dahinter: Kinder müssten doch lernen, was bei Multiplikation und Division wirklich passiert, und überhaupt ist der Taschenrechner ja vielleicht nicht immer vorhanden.

Neuronale Netze als Blackbox

Ein ganz ähnliches Phänomen beschäftigt aktuell Forschende verschiedenster Gebiete. "Machine Learning" mit sogenannten neuronalen Netzen erweist sich als hocheffektive Methode, wissenschaftliche Phänomene zu simulieren. Doch dadurch steige die Gefahr, dass man die Berechnungen nicht mehr verstehe, warnen Kritiker. Künstliche Intelligenz wisse schließlich von sich aus nichts über Physik. Es entstehe eine sprichwörtliche Blackbox, ein schwarzer Kasten, in der die Berechnung verschwinde – und der Erkenntnisgewinn gleich mit.

Das Tabu wird gebrochen

Doch in den vergangenen Jahren hat sich die Situation verändert. Einerseits funktionieren neuronale Netze (in Fachkreisen spricht man lieber von Machine-Learning oder "maschinellem Lernen") ausgesprochen gut, und andererseits gelingt es besser denn je, ihnen doch physikalisches Wissen mitzugeben und ihre Arbeitsweise zu verstehen.

Einem Team von der Universität Princeton ist es nun gelungen, mit Machine Learning einen Durchbruch beim Verständnis der Bildung von Eis zu erzielen; die Ergebnisse wurden in der Fachzeitschrift "Proceedings of the National Academy of Sciences" publiziert.

Nie dagewesene Größe

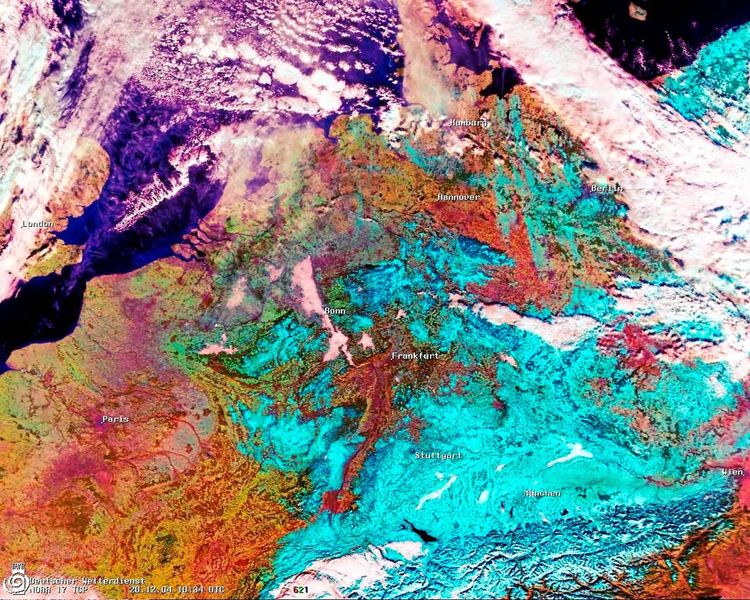

"Die Kristallkeimbildung von Eis ist eine der größten Unbekannten in Wettermodellen", erklärt Pablo Debenedetti, Koautor der neuen Studie. Er spricht von einem riesigen Schritt vorwärts: "Wir konnten Systeme in einer Größe simulieren, wie das bisher für quantenphysikalische Berechnungen undenkbar war."

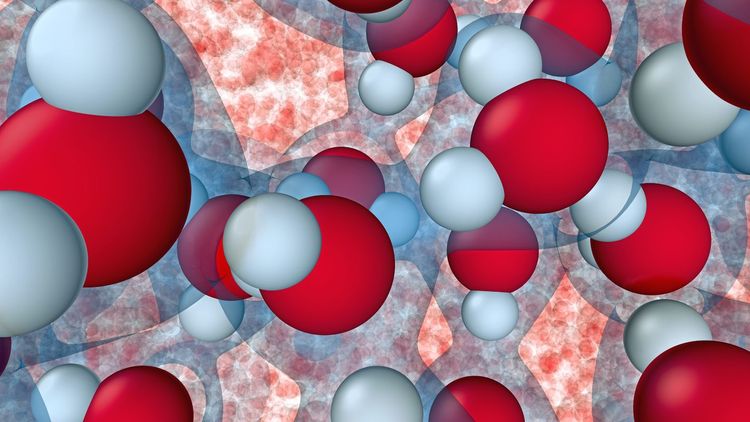

Die Simulationen umfassten bis zu 300.000 Atome und wurden auf einem der leistungsfähigsten Supercomputer der Welt durchgeführt, der sich im Oak Ridge National Laboratory im US-amerikanischen Tennessee befindet. Möglich war diese Verbesserung, indem ein neuronales Netz trainiert wurde, die Ergebnisse aufwendiger, aber ähnlicher Rechenschritte vorherzusehen. "Der Trick besteht darin, dass der Computer aufgrund einiger physikalischer Prinzipien das, was bei einigen wenigen Konstellationen von Molekülen passiert, auf unzählige Arrangements von Molekülen in viel größeren Systemen umlegen kann", erklärt Roberto Car vom Forschungsteam.

Das Eis ist gebrochen

Eis steht in der Popkultur seit William Gibsons Kultbuch "Neuromancer" auch für Hindernisse in Computernetzwerken, die es zu überwinden gilt. In diesem Sinn ist auch die Aussage der Forschenden aus Princeton zu verstehen, wenn sie erklären, bei der Simulation von gefrierendem Wasser das "Eis gebrochen" zu haben. Es geht nicht so sehr um das Entdecken konkreter neuer Effekte beim Gefrieren von Wasser, sondern um die Simulation des gesamten Prozesses auf der Ebene der Moleküle.

Bisher wurde bei Klimamodellen nämlich auf Beobachtungsdaten aus Laborexperimenten zurückgegriffen, die nur unter bestimmten Bedingungen gültig waren. Nun sei es erstmals möglich, auch die Bildung von Eis unter extremen Bedingungen besser vorherzusagen, etwa auf anderen Planeten, schreibt die Forschungsgruppe.

Die Erfüllung eines Traums

"In gewissem Sinn wird ein Traum wahr", erklärt Car, der vor 35 Jahren an der Universität Princeton Pionierarbeit bei der Simulation von Molekülen auf Quantenebene leistete. "Wir haben damals gehofft, dass es möglich wäre, Systeme wie dieses zu studieren, aber wir waren auf Entwicklungen in komplett anderen Forschungsfeldern angewiesen." Die Fortschritte in den Gebieten künstliche Intelligenz und Datenwissenschaften hätten nun den Unterschied gemacht.

Charakteristikum von Quantensystemen

Die Simulation der Bildung von Kristallkeimen war also im Prinzip schon bisher möglich. Doch die genaue Modellierung der Bewegungen von Molekülen "ab initio", also direkt nach den Gesetzen der Quantenphysik, ohne grobe Vereinfachungen, gestaltet sich normalerweise enorm aufwendig. Auf das Phänomen machte schon Nobelpreisträger Richard Feynman in einem 1982 veröffentlichten und heute als bahnbrechend geltenden Artikel aufmerksam, der auch als Geburtsstunde des Konzepts des Quantencomputers gilt. Er rechnete vor, dass Quantensysteme um vieles komplexer seien als Probleme der klassischen Physik und sie schnell jeden Computer überfordern würden. Nur ein Computer, der diese Komplexität zu seinem Vorteil nutze, könne den Herausforderungen gerecht werden.

Doch Quantencomputer warten nach einigen Teilerfolgen immer noch auf ihren Durchbruch als wissenschaftliche Instrumente. Nun scheinen Methoden der künstlichen Intelligenz zumindest manche der komplexeren quantenphysikalischen Fragestellungen zugänglicher zu machen.

Neuronale Netze werden erklärbar

Neuronale Netze haben allerdings immer noch den Nimbus des Mysteriösen, weil sie nicht von Hand programmiert werden, sondern lernen, autonom Probleme zu lösen. Das Bild von Neuronen wird nicht umsonst herangezogen: Wie im Gehirn ist es auch hier ein komplexes Netzwerk, das ein Ergebnis produziert, ohne dass die Einzelschritte nachvollziehbar wären. Durch den verbreiteten Einsatz dieser Methoden, vor allem in der Bild- und Spracherkennung, entstehen auch rechtliche Fragen. Wer ist für ein System verantwortlich, das ohne menschliches Zutun Aufgaben löst und dessen Entscheidungsfindungsprozess nicht weiter untersucht werden kann? Deshalb wird in letzter Zeit in Forschung investiert, die "erklärbare" künstliche Intelligenz verspricht. Der Algorithmus soll in der Lage sein, zumindest einige Zwischenschritte seiner Arbeit zu dokumentieren.

Das Team aus Princeton löste das Problem so, dass nur bestimmte Teilschritte mit Machine Learning bewältigt wurden. So leidet das Verständnis des gesamten Vorgangs nicht unter dem Einsatz der Blackbox.

Auf dem Weg zur Selbstverständlichkeit

Machine Learning ist jedenfalls auf dem besten Weg, in der Wissenschaft so selbstverständlich zu werden, wie es der kleine Taschenrechner auf Smartphones ist, den auch der Autor manchmal, heimlich und verschämt, für Grundrechenarten benützt, in der Hoffnung, dass nie jemand davon erfährt. (Reinhard Kleindl, 9.8.2022)