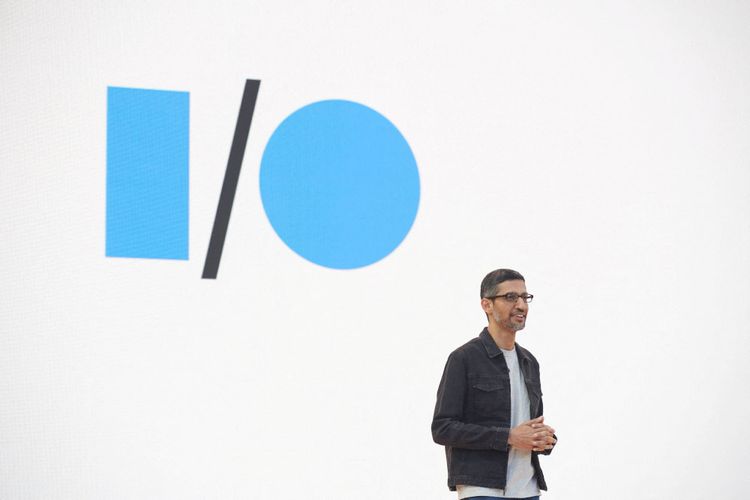

Google-Chef Sundar Pichai ist bei Chat-KIs noch zurückhaltend.

Der Hype rund um den Start von Chat GPT hat eine für Google existenzielle Frage aufgeworfen: Sind KI-Chatbots nicht eigentlich die besseren Suchmaschinen? Schließlich liefern Large Language Models nicht nur Informationen, sie bereiten sie auch gleich für die Userinnen und User auf. "Nein", meint man bei Google. Beim Suchmaschinenriesen sieht man die Sprachmodelle zwar auf einem guten Weg, noch sind sie aber voreingenommen, toxisch – und manchmal lügen sie auch einfach.

Laut einem Bericht von CNBC sprachen Alphabet-CEO Sundar Pichai und der KI-Chef von Google, Jeff Dean, kürzlich in einem internen Meeting über den Aufstieg von Chat GPT. Ein Mitarbeiter wollte wissen, ob die Einführung des Bots eine verpasste Chance für Google sei. Darauf antworteten Pichai und Dean, dass die eigenen Sprachmodelle genauso leistungsfähig seien wie jenes von Open AI. Man müsse jedoch "konservativer" vorgehen, als es ein kleines Start-up könne, da die Technologie Risiken für die Reputation des Unternehmens berge.

Die Bedenken des Mitarbeiters sind dennoch verständlich, schließlich wird Chat GPT von Open AI entwickelt, einem Unternehmen, das eng an Microsoft gebunden ist, einen der größten Konkurrenten von Google. Dennoch sei man bei Google bestrebt, Sprachmodelle im Jahr 2023 verstärkt in den eigenen Produkten zu verwenden. Man wolle es aber "richtig" machen, wie Pichai hinzufügte.

Google nutzt Sprachmodelle im Hintergrund

Google hat bereits mehrere Large Language Models, die mit der Leistungsfähigkeit von Chat GPT vergleichbar sein sollen. Dazu gehören BERT, MUM und LaMDA, die aktuell alle zur Verbesserung von Suchergebnissen eingesetzt werden. Jedoch bemerkt man als User davon recht wenig, denn die Modelle arbeiten im Hintergrund und versuchen die Absichten der User besser zu verstehen. Laut Google hilft etwa MUM dabei, wenn eine Suchanfrage auf eine persönliche Krise des Nutzers hindeutet. Die Suchergebnisse sollen diese Personen dann zu Notrufnummern und Hilfehotlines leiten. Google ist mit der Einführung von KI-Systemen generell vorsichtig. So gibt es zwar die AI Test Kitchen, bei der Benutzer Sprachmodelle ausprobieren können, diese sind aber im Umfang streng limitiert.

Aber auch die Konkurrenz war in der Vergangenheit und nach zahlreichen peinlichen Fehlschlägen vorsichtig, bis eben Open AI mit Chat GPT diesen Kurs änderte. Das Ergebnis war ein regelrechter Hype um das Sprachmodell. Obwohl diese Modelle eine enorme und beeindruckende Leistungsfähigkeit haben, stoßen sie immer wieder auf bekannte Probleme. So verstärken sie etwas soziale Vorurteile, weil diese oft schon in Trainingsdaten vorhanden sind. Diese werden der KI also eingeimpft. Außerdem machen sich Nutzer gerne einen Spaß daraus, die KI auszutricksen. Zwar verfügt Chat GPT über Sicherheitsfeatures, um gefährliche Inhalte auszufiltern, diese ließen sich aber umgehen, indem Nutzer den Bot aufforderten, er möge sich vorstellen, er sei eine böse KI.

Der Schwindler in KI-Form

Für Googles Suchergebnisse dürfte aber ein anderer Aspekt relevanter sein: die Zuverlässigkeit von Informationen. Denn Sprachmodelle sind manchmal auch einfach Lügner und erfinden Informationen. Eine Tatsache, die DER STANDARD im Test der KI nachvollziehen konnte. In unserem Fall wurde ein quicklebendiger Kollege für tot erklärt. In einem anderen Fall riet Chat GPT dazu, der Muttermilch zerbrochene Keramikscherben beizumengen, um deren Verdauung zu fördern.

Derartige Resultate auf Suchanfragen will man bei Google unbedingt vermeiden: KI-Chatbots würden einfach Dinge erfinden, wenn sie sich nicht sicher seien. "Sie werden Ihnen einfach sagen, dass Elefanten die größten Eier legen oder so etwas", wird der KI-Chef zitiert. Das deckt sich mit den Ergebnissen einer von Google intern erstellten Studie: Das Problem sei, dass Large Language Models "kein wahres Verständnis der Welt haben und zu Halluzinationen neigen". Außerdem fehle es schlicht an einer Kompetenz, die im Umgang mit Informationen aus dem Netz immer wichtiger wird: eine fundierte Quellenkritik. (red, 15.12.2022)