Experten betonen immer wieder, dass eine KI kein Verständnis der Welt hat – der Hype bleibt trotzdem.

(Dieses Bild wurde mit der Bilder-KI Midjourney generiert. Der Prompt lautete: "realistic picture of a robot standing on a pile of cash. The robot has a writing on his body: "GPT 4" --ar 16:9")

Eines muss man ChatGPT schon lassen: Der Chatbot von OpenAI hat es in den vergangenen Monaten geschafft, die Fantasie vieler Menschen anzuregen. Der Umstand, dass die Software sehr überzeugende – und vor allem menschlich klingende – Antworten auf beliebige Fragen und Aufgaben liefern kann, verleitet geradezu zur Anthropomorphisierung. Dass die damit beschäftigten Forscher sich seit Wochen den Mund fusselig reden, um zu betonen, dass dahinter keine Intelligenz, kein Verständnis der Welt steckt, hat am Hype bisher recht wenig geändert.

Für Hersteller OpenAI ist das einerseits erfreulich, bekommt das Unternehmen so doch nicht nur viel öffentliche Aufmerksamkeit, durch Partnerschaften wird gerade auch ziemlich viel Geld in die Firmenkasse gespült. Gleichzeitig entstehen dadurch aber geradezu absurd überzogene Erwartungshaltungen an die weitere Entwicklung. Entsprechend sah sich Open-AI-Boss Sam Altman vor einigen Wochen zu dem ungewöhnlichen Schritt veranlasst, die Erwartungen an das hinter all dem stehende, neueste Sprachmodell GPT-4 öffentlich zu bremsen – oder es zumindest zu versuchen.

GPT-4 ist da

Nun ist GPT-4 tatsächlich da, und wie sich zeigte, hatte Altman – wenig überraschend – recht. Das Sprachmodell stellt sich nicht als die ganz große Revolution, sondern als eine Evolution des Vorgängers dar. Allerdings eine, die durchaus interessante Verbesserungen bringt.

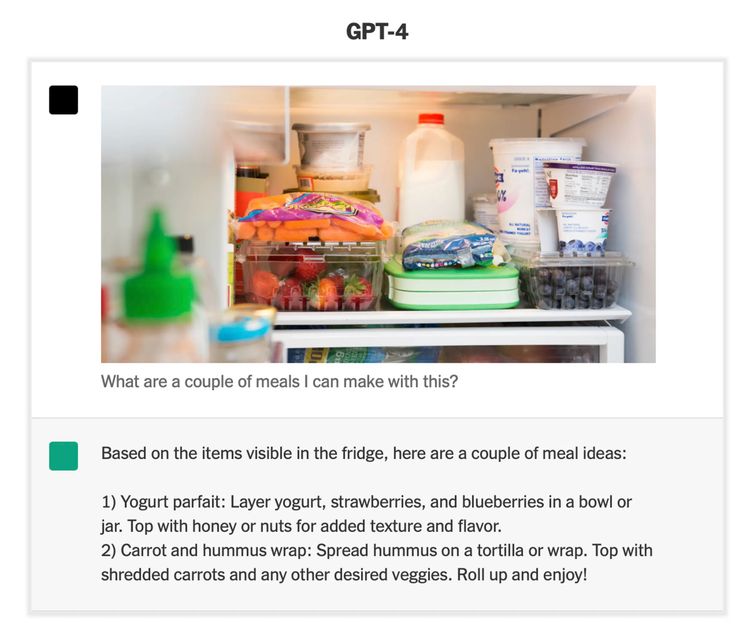

Die vielleicht wichtigste Neuerung: GPT-4 ist jetzt multimodal, das heißt, es kann neben Texten auch mit Bildern umgehen. Das Konzept ist zunächst einmal nicht ganz neu: Google verwendet etwa für gewisse Aufgaben in seiner Suchmaschine mittlerweile ein multimodales Modell, und mächtige Bilderkennung gibt es ohnehin schon länger bei vielen Tools unterschiedlicher Hersteller. Das Interessante ist in diesem Fall aber, dass hinter all dem ein sehr großes Sprachmodell steht, woraus sich allerlei spannende Möglichkeiten ergeben.

Beeindruckende Dinge

Wie OpenAI betont, ist es damit etwa möglich, das Innere des eigenen Kühlschranks zu fotografieren und einen auf GPT-4 basierenden Chatbot nach einem passenden Rezept zu fragen – das dann prompt geliefert wird. Im Detail muss man natürlich auch hier aufpassen. Wer die offizielle Demonstration näher betrachtet, dem wird etwa auffallen, dass in einem der vorgeschlagenen Rezepte eine Zutat vorkommt, die gar nicht im Bild ist – eine Tortilla. Aber dass solche großen KI-Systeme zum "Halluzinieren" neigen, sollte sich mittlerweile ja überall herumgesprochen haben.

Auf andere visuelle Demos hatte OpenAI schon in seiner Präsentation selbst verwiesen, als die KI anhand der groben Zeichnung einer Webseite den passenden Code zu deren Erstellung liefert. Generell darf mit Spannung erwartet werden, was andere Firmen dann noch mit diesen Möglichkeiten anfangen werden. So hat etwa die Firma Diagram schon angekündigt, dass man auf Basis von GPT-4 ein Tool entwickeln will, das Feedback zu Designs geben soll.

Für die breite Masse ist die Multimodalität derzeit allerdings noch blanke Theorie, ist sie doch noch gar nicht öffentlich verfügbar. Der Grund dafür ist laut OpenAI, dass die Bilderkennung derzeit noch sehr langsam arbeitet, vor einer Freigabe soll also noch an der Performance geschraubt werden.

Am Rande sei erwähnt, dass auch die Kombination aus Multimodalität und großen Sprachmodellen technisch gesehen jetzt keine Neuerfindung von OpenAI ist. So haben etwa die deutsche KI-Firma Aleph Alpha und das Google-Schwesterunternehmen Deepmind schon von ein paar Jahren erstmals beides verbunden.

Sprache

Schwer zu quantifizieren, aber generell verbessert wurde das Sprachverständnis der KI. Sie macht weniger Fehler und liefert generell etwas weniger mechanisch klingende Texte, wie erste Tests bestätigen. Auch bei Gedichten ist die Software nun zumindest eine Spur besser. Vor allem aber kann GPT-4 nun mit erheblich längeren Texten umgehen, also etwa ganze Forschungspapiere zusammenfassen.

Das neue Limit liegt nun bei 32.000 Token, was laut OpenAI rund 50 Seiten Text entspricht. Auch da gibt es derzeit aber noch einen wichtigen Disclaimer: Der Hersteller rät dazu diese Grenze vorerst nicht auszureizen, da das noch nicht fehlerfrei funktioniert.

Die Testfrage

In einem Bericht über GPT-4 darf natürlich nicht der Hinweis auf eine jener Grafiken fehlen, die OpenAI bei der Präsentation besonders stark in den Vordergrund gestellt hat. Schneidet die neue Generation des Sprachmodells doch bei vielen standardisierten Tests – von der Rechtsanwaltsprüfung bis zu Statistikkursen – erheblich besser als die Vorgänger ab.

Das macht sich fraglos in einer Grafik sehr gut, doch auch hier muss man vorsichtig sein, um keine falschen Schlüsse zu ziehen. Nur weil eine KI sehr gut bei diesen Tests ist, heißt das nicht, dass sie dieselben Fähigkeiten hat wie ein Mensch, der diesen Test besteht. So hatte etwa KI-Expertin Melanie Mitchell vor einigen Wochen in einer Artikelserie darauf verwiesen, dass das im Endeffekt nur klar macht, dass die KI sehr gut für den Test gelernt hat.

Fehleranfälligkeit

Wie von solchen großen Sprachmodellen gewohnt, kann auch GPT-4 natürlich keine aktuellen Informationen bieten, dessen Wissensstand endet derzeit im Jahr 2021, was schlicht daran liegt, dass solche System extrem aufwändig zu trainieren und optimieren sind. Wer sich jetzt wundert, dass der auf GPT-4 basierende Bing Chat sehr wohl aktuelle Informationen hat: das liegt daran, dass dort die Ergebnisse mit klassischen Suchinformationen kombiniert werden. "Bing Orchestrator" nennt Microsoft das.

Dass auch GPT-4 weiterhin sehr viele Fehler macht – also eben sehr überzeugt Falsches von sich gibt – sollte ohnehin nicht verwundern. Mussten dies doch in den vergangenen Wochen bereits viele Tester des neuen Bing Chats herausfinden, der – wie sich nun herausstellt – bereits GPT-4 als Basis verwendet.

OpenAI ist in dieser Hinsicht übrigens wenig Vorwurf zu machen, so hat Sam Altman auch jetzt wieder bei der Vorstellung von GPT-4 betont, dass auch das neue Sprachmodell wieder viele Fehler produziert und zunächst auf viele eindrucksvoller wirkt, als es eigentlich ist. Das Unternehmen war generell in den vergangenen Wochen bemüht, die Erwartungen an den aktuellen KI-Hype zumindest ein bisschen zu kalmieren.

Aus OpenAI wird ClosedAI

Was allerdings bei all dem auch auffällt, ist das von dem "Open" in OpenAI mittlerweile praktisch nichts mehr übrig ist. Dass die Firma selbst im offiziellen "Technical Report" kaum technische Details zu GPT-4 veröffentlicht hat, hat umgehend zu viel Kritik aus der KI-Community geführt. So verrät man etwa nicht einmal, wie viele Parameter GPT-4 hat, ein Wert, der eine wichtige Rolle im Vergleich zu anderen großen Sprachmodellen von Firmen wie Google oder Facebook spielt. Und auch sonst bleiben sehr viele Fragen offen.

Die Offenheit war "ein Fehler"

Dass das auch kein Zufall ist, betonte das Unternehmen im Rahmen eines Interviews mit "The Verge". Dort sprach man nun davon, dass das offene Teilen von Forschungsergebnissen – wie es bislang in der KI-Welt üblich war – ein Fehler gewesen sei. Als Grund dafür verweist man auf die damit einhergehenden Gefahren. So eine große KI sei ein sehr mächtiges Tool, das auch leicht missbraucht werden könne – da sei eine Open-Source-Herangehensweise keine weise Entscheidung. (apo, 17.3.2023)