Wenn man über Bilder-KIs spricht, dürften viele an Midjourney denken. Diese wird vom Anbieter als Clouddienst betrieben, den man gegen Abogebühren in der Regel über die Kommunikationsplattform Discord steuert.

Doch es gibt auch eine offene und damit kostenlos nutzbare Alternative. Sie nennt sich Stable Diffusion. Seit ihrer Veröffentlichung hat sie, lange unbemerkt von der breiteren Öffentlichkeit, unzählige Enthusiasten angelockt, die auf ihrer Basis eigene KI-Modelle entwickeln und Tools bauen, um diese verwenden zu können.

Und das eröffnet die Möglichkeit, Bilder auf dem eigenen Rechner zu generieren. Ganz ohne Cloudanbindung und Bezahlabo. Zwei Tools machen den Einstieg dabei selbst Anfängern sehr leicht. Ein kleiner Guide.

Disclaimer

Vorweg allerdings eine kurze Warnung: Wer Bilder halbwegs flott und ohne Probleme erzeugen möchte, sollte tunlichst eine aktuellere Grafikeinheit von Nvidia oder AMD zur Verfügung haben – hier sind auch integrierte Grafikchips mitgemeint. Deren spezialisierte Kerne sind dafür ausgelegt, mit den Programmiersprachen Cuda bzw. OpenCL angesprochen zu werden. Ist eine solche GPU nicht vorhanden, laufen die beiden vorgestellten Bildgenerierungs-Tools über den normalen Prozessor. Dessen Rechenkerne sind bei der Abarbeitung solcher Aufgaben allerdings deutlich langsamer und ineffizienter, weswegen man viel länger – oft den zehnfachen Zeitraum oder mehr – auf Ergebnisse warten muss.

Dieser Guide stellt Lösungen vor, die auf Windows, MacOS und Linux laufen – allerdings nicht mit Apples eigenem Chips der M-Serie. Auch für solche gibt es aber ein (mangels eines entsprechenden Rechners nicht getesteten) Tool unter dem Namen DiffusionBee, das ebenfalls eine einfache Inbetriebnahme verspricht.

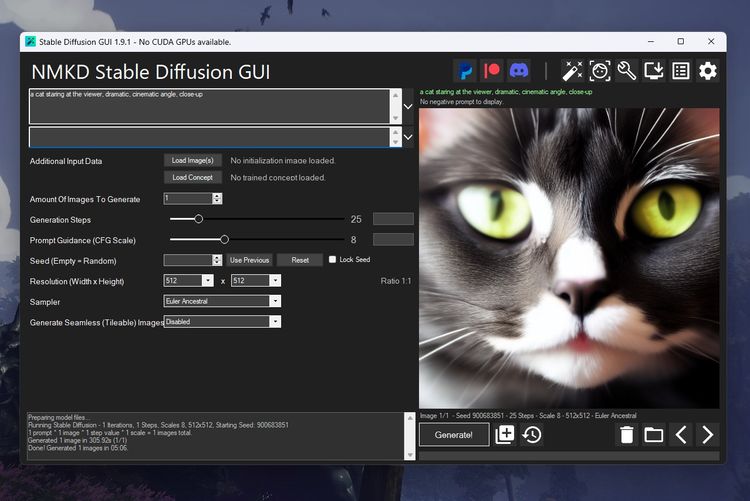

NMKD Stable Diffusion GUI (Windows)

Die zugänglichste Lösung, um Stable Diffusion auf dem eigenen Rechner Bilder erzeugen zu lassen, ist die NMKD Stable Diffusion GUI. Diese lässt sich kostenlos oder gegen optionale Spende über die Plattform Itch.io herunterladen. Sie ist allerdings aktuell nur für Windows verfügbar. Wer schnell starten möchte, sollte die Variante mit inkludiertem Stable-Diffusion-Modell wählen. Das Tool kommt in einem ZIP-Archiv, das einen Ordner beinhaltet, welcher beliebig platziert werden kann.

Nach dem Start sollte eine Nvidia-Karte automatisch erkannt werden. Bei AMD-Karten muss der Ausführungsmodus umgestellt werden. Da hierfür ein angepasstes KI-Modell notwendig ist, muss das im Download integrierte Modell zuerst vom CKPT ins ONNX-Format konvertiert werden. Auch Safetensor-Modelle können für die Verwendung direkt mit diesem Programm konvertiert werden. Bei der ersten Bildgenerierung werden fehlende Komponenten außerdem automatisch nachgeladen. Eine Limitierung muss aber beachtet werden: Unterstützt werden nur Modelle bis Stable Diffusion 1.5, (noch) nicht aber welche der neueren Ausgaben 2.0 und 2.1.

Der grundlegende Aufbau ist übersichtlich. Es präsentieren sich Eingabefelder für den Prompt (also die "Bildbeschreibung", die man dem KI-Modell füttert) und negative Prompts (Elemente, die bei der Generierung vermieden werden sollen). Ebenso einstellbar sind Bildgröße, die Anzahl der Generierungsschritte und die "Prompt Guidance", die festlegt, wie streng sich die KI an den Prompt halten soll. Generell gilt: Je größer das Ergebnis sein soll und je mehr Erstellungsschritte eingestellt werden, desto länger dauert es zum Ergebnis. Zudem steigen die genutzten Ressourcen, insbesondere in puncto Arbeitsspeicher der Grafikkarten. Wird dieses Limit überschritten, scheitert die Bilderzeugung.

Wer möchte, kann auch den "Sampler" ändern. Darunter versteh man den Visualisierungsalgorithmus, der den Output des KI-Modells in ein visuelles Ergebnis umsetzt. Während das eingegebene Motiv in der Regel unverändert bleibt, können unterschiedliche Sampler in stilistischer Hinsicht stark voneinander abweichen.

Fortgeschrittene Optionen sind das Laden von Bildern als Vorlage für die KI oder von in Dateiform gepackten "Konzepten", ebenfalls für stilistische Effekte. Mit der Einstellung "Generate Seamless Images" lassen sich wiederum Texturen erstellen, was für Grafikdesign, 3D-Modelling und Spieleentwicklung hilfreich ist.

Unter der Haube kann die NMKD Stable Diffusion GUI noch um einiges mehr. Mit entsprechender Hardware – die Rede ist hier von Server- und Workstation-Grafikkarten mit 24 GB RAM oder mehr – kann es etwa auch genutzt werden, um eigene KI-Modelle auf Basis von Stable Diffusion anzulernen.

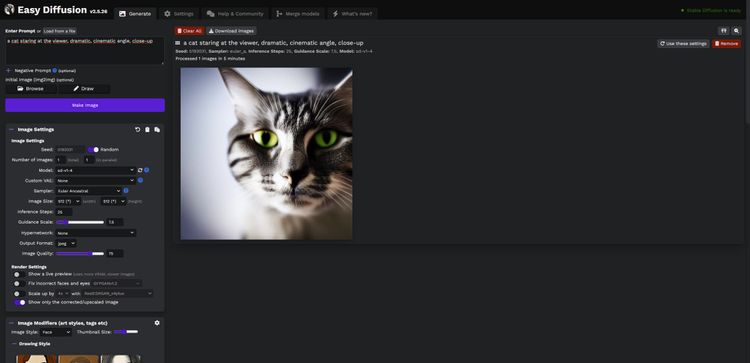

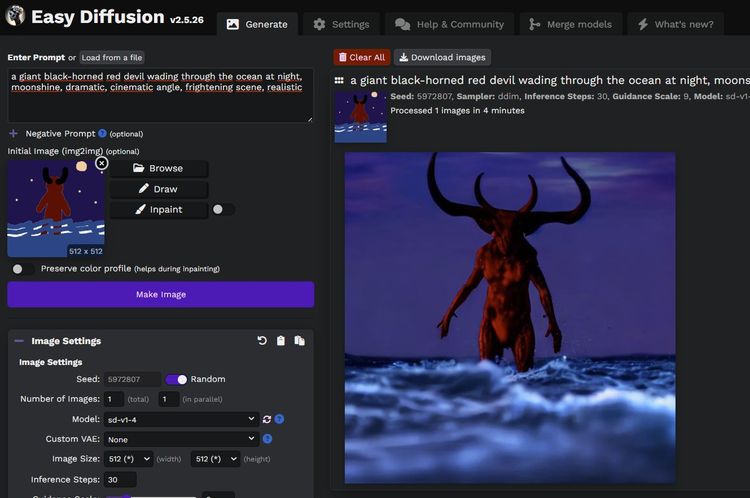

Easy Diffusion (Multiplattform)

Ebenfalls einfach per Download und Archivextraktion zu installieren ist Easy Diffusion, das für Windows, Linux und MacOS entwickelt wird. Die Multiplattformunterstützung ergibt sich auch daraus, dass hier die Bildgenerierung im Browser gesteuert wird. Effektiv wird beim Start des Tools ein lokaler Server eingerichtet. Der lässt sich, wenn man möchte, auch so einrichten, dass man ihn auch von anderen Geräten aus erreicht. Auf diese Weise steht dann auch der Nutzung über ein Handy oder Tablet mit Android bzw. iOS nichts im Wege.

Hier bekommt man schon zu Beginn nicht nur die schon bei der NMKD Stable Diffusion GUI erwähnten Optionen präsentiert, sondern gleich viele mehr. Teilweise handelt es sich dabei um Funktionen, die bei ersterem Programm in Untermenüs schlummern, teilweise aber auch um welche, über die dieses nicht verfügt.

Dazu gibt es Unterstützung für Stable Diffusion 2.0 und 2.1 sowie eine Reihe visueller Konzepte mit Vorschau, die sich per Klick hinzufügen lassen. Auch kann schon am Hauptbildschirm das verwendete Modell gewechselt werden, sofern man bereits andere heruntergeladen hat. Akzeptiert werden die Varianten CKPT und Safetensor.

Komfortabel können Bilder als Vorlage geladen oder mit einem einfachen Tool gezeichnet werden. Auch Inpainting ist integriert, womit sich gezielt bestimmte Teile eines Bildes verändern lassen und der Rest erhalten wird. Natürlich gilt auch hier: Je höher Auflösung und eingestellter Berechnungsaufwand, desto länger muss man warten. Insbesondere, wenn man die Bildgenerierung über den normalen Prozessor laufen lassen muss.

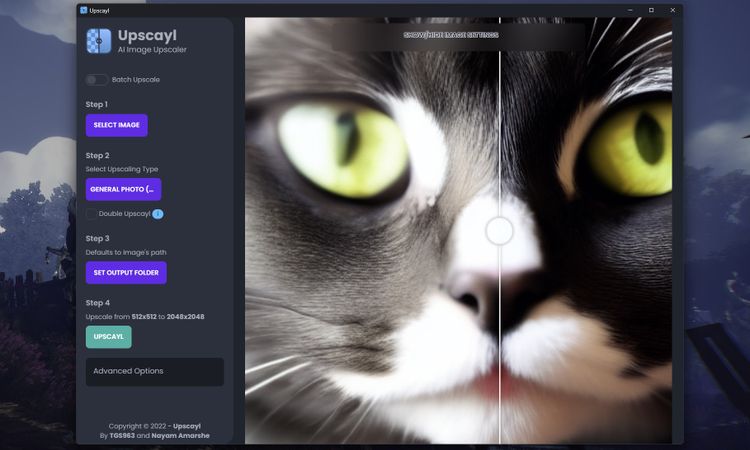

Bildvergrößerung mit Upscayl (Windows, MacOS, Linux)

Wie groß man ein KI-Bild generieren lassen kann, hängt primär von den eigenen Zeit- und Hardwareressourcen ab. Allerdings kann es bei höheren Auflösungen auch zu unerwartetem Verhalten bei der Bildgenerierung und entsprechend "kaputten" Ergebnissen kommen. Als Umweg bieten sowohl Easy Diffusion, als auch das NMKD-Tool integriertes KI-Upscaling mithilfe des neuralen Netzwerks GFPGAN an, die allerdings nicht immer gute Resultate bringen. Bei Easy Diffusion können andere Netzwerke, die auf diese Aufgabe spezialisiert sind, nachgeladen werden. Das allerdings bringt etwas Recherche und Aufwand mit sich.

Eine einfache Lösung stellt die Verwendung des Open-Source-Tools Upscayl dar, welches für macOS, Linux und Windows verfügbar ist. Es bietet ein simples, weitgehend selbsterklärendes Interface und beschränkt sich ausschließlich auf die Vergrößerungsfunktion.

Die Bedienung ist einfach. Man lädt ein Bild und legt fest, mit welchem neuralen Netzwerk es vergrößert werden soll. Dabei stehen verschiedene Netzwerke bzw. Netzwerkvarianten zur Verfügung, die unterschiedlich gut geeignet für verschiedene Stile sind.

Daher hier eine Liste der subjektiv besten Einstellungen für diverse Szenarien (basierend auf Upscayl 2.0.1):

- Fotos von Personen oder Tieren: Ultrasharp

- Landschaft: Remacri Stadt / Architektur: Ultrasharp

- Geräte: Ultrasharp / Ultramix Balanced

- Zeichnungen/Gemälde: Remacri

- Digitale Kunst / Cartoons: Digital Art

Anschließend kann noch der Ordner gewählt werden, in welchem das vergrößerte Bild gespeichert werden soll. Andernfalls landet es im gleichen Ordner, in dem sich das Originalbild befindet.

Aussuchen kann man sich auch das Dateiformat für die Speicherung. Und auch Vergrößern von mehreren Bildern auf einmal ist über die Batch-Funktion möglich. Upscayl lässt sich freilich nicht nur für KI-Erzeugnisse verwenden, sondern für beliebige Bilder.

Was ist mit Intel Arc?

Eine schlechte Nachricht gibt es an dieser Stelle für Besitzer einer Intel Arc-Karte – wie meine Wenigkeit – oder Nutzer einer integrierten Intel Xe-Grafikeinheit. Für diese gibt es zwar mittlerweile Lösungen, um Stable Diffusion auf den spezialisierten XMX-Kernen laufen zu lassen. Das setzt allerdings zahlreiche Einrichtungsschritte voraus.

Es besteht im Prinzip die Wahl zwischen drei Möglichkeiten: Langsamen CPU-Berechnungen, rein unter Windows laufenden Varianten, die allerdings noch sehr fehlerhaft und instabil sind. Und dem verlässlichsten Weg mit einer Einrichtung einer Ubuntu-Linuxinstallation über das "Windows Subsystem for Linux". Für Nutzer mit wenig Vorwissen, die sich einfach nur auf ihrem Rechner mit Bildgenerierung spielen wollen, ist das kein zumutbarer Prozess. Wer es trotzdem wagen möchte, findet verlinkte Anleitungen unter dem Artikel.

KI-Modelle

Die mit den grafischen Oberfläche mitgelieferten bzw. automatisch nachinstallierten KI-Modelle sind die "Standard"-Ausführungen, die von den Entwicklern von Stability AI freigegeben wurden. Es gibt aber, wie erwähnt, längst eine große Auswahl an spezialisierten Stable-Diffusion-Modellen – sei es für fotorealistische Resultate, auf Fantasy-Illustrationen getrimmte Werke oder auch Bildmaterial der eher anzüglichen Sorte.

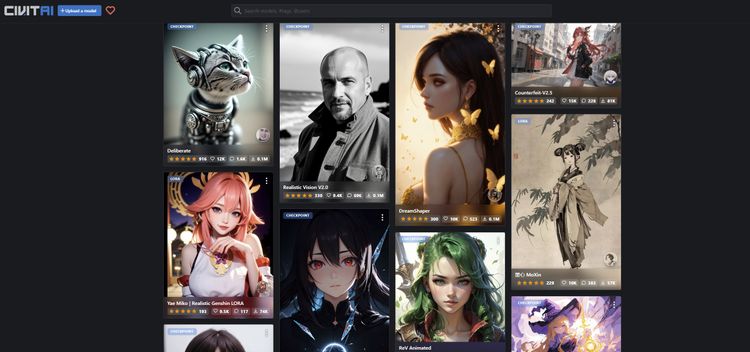

Eine öffentliche Sammlung nebst zahlreicher Beispielbilder bietet die Plattform CivitAI. Je nach genutztem Tool sollte dabei die zugrundeliegende Stable Diffusion-Version beachtet werden. Zudem kann vor dem Einsatz der Modelle eine Konvertierung in ein passendes Format notwendig werden.

Prompts

Abseits geeigneter Hardware und Einstellungen steht und fällt die Qualität generierter Bilder mit den eingegebenen Prompts. Wer lernen möchte, wie komplexere Befehle für gute Ergebnisse aussehen, findet dazu eine Reihe Tutorials im Netz, kann aber auch einfach Bilder auf CivitAI sichten, bei denen in der Regel Prompt und Einstellungen angegeben sind.

Man kann auch Sprachmodelle wie ChatGPT bemühen und sich nach eigenen Vorgaben Prompts verfassen lassen, die ebenfalls gut funktionieren können. Eine auf Midjourney abzielende Anleitung, die aber auch für Stable Diffusion funktioniert, findet sich unter diesem Link. (gpi, 1.4.2023)