Forscher sind dem Ziel, unser Gehirn "übersetzen" zu können, einen Schritt näher gekommen. Ein Team der National University in Singapur und der Hongkong University ist es gelungen, Daten von Hirnströmen mit einer Bildgenerierungs-KI zu verknüpfen und damit Videos zu erzeugen. Diese zeigen relativ akkurat, was ein Proband zum Zeitpunkt der Messung gesehen hat.

Zunächst nutzte man einen Datensatz aus öffentlich verfügbaren Videos und dazu gehörenden fMRT-Scans (funktionelle Magnetresonanztomographie). Die fMRT-Scans wurden in Daten übersetzt und in Kombination mit dem Videomaterial dazu verwendet, ein eigenes Modell der Bilder-KI Stable Diffusion zu trainieren.

fMRT trifft Stable Diffusion

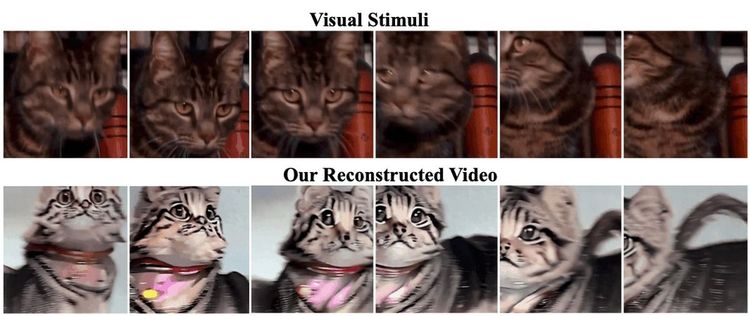

Um das System, das den Namen "MinD-Video" erhielt, zu testen, ließ man es aus dem fMRT-Daten Videos erzeugen. Die Ergebnisse, so zeigt auch das via arXiv als Preprint veröffentlichte Paper, sind durchaus beeindruckend. Die KI-Reproduktionen entsprechen inhaltlich stark den jeweiligen Videos, zeigen also die gleichen Szenen, Bewegungen und Subjekte. Gröbere Abweichungen gibt es vorwiegend bei Details und der Farbgebung. Laut den Wissenschaftlern lag die Genauigkeit der Videos bei der Abbildung des Gesehenen bei 85 Prozent. Ergebnisse zeigt man auch auf einer eigens eingerichteten Website. Der Code für MinD-Video soll bald auf Github veröffentlicht werden.

Die Wissenschaftler sehen in dem Ergebnis einen weiteren Nachweis dafür, dass der visuelle Kortex, dessen fMRT-Daten man auswertete, eine tragende Rolle für die visuelle Wahrnehmung spielt und seinem Aufbau nach Signale nach einem hierarchischen Verfahren abarbeitet, das zuerst strukturelle Informationen analysiert und dann immer stärker auf visuelle und abstrakte Informationen umschwenkt, zitiert Vice.

Sie sehen für derlei Technologie wichtige Anwendungsfelder in der Zukunft. Als Beispiele nennen sie etwa den Einsatz in der Neurowissenschaft oder auch sogenannte Brain-Computer-Interfaces, also Geräte, die sich mittels Hirnsignalen steuern lassen oder via Implantat auch in elektrische Impulse an das Denkorgan abgeben können.

Sie sind nicht das erste Team, das diesen Ansatz verfolgt hat. Auch Forscher der Osaka University haben bereits mit fMRT-Daten und Stable Diffusion experimentiert. Ihnen war es gelungen, auf Basis der Hirnaktivitäten treffende hochauflösende Standbilder zu generieren. (gpi, 29.05.2023)