Die "Transformation Lounge" in der Post-City Linz ist mit knallroten und birkenholzfarbenen Stühlen ausgestattet, dazwischen reihen sich Container und Gerüstbauten mit allerlei Pflanzen. Beleuchtete Plastikbehältnisse dienen als Wegweiser und Ortsangabe. Fachpublikum trifft auf Studierende, Kunstschaffende treffen auf Forschende. Es ist laut, es ist feuchtwarm, aber die meisten scheinen glücklich, wieder hier zu sein. Inmitten dieser Szenerie treffen wir Winnie Soon.

Das künstlerische Projekt "Unerasable Characters Series" ("Serie unauslöschbarer Schriftzeichen") von Winnie Soon gewinnt dieses Jahr die Goldene Nica des Prix Ars Electronica in der Kategorie "Künstliche Intelligenz und Life Art". Das Medienkunstwerk beschäftigt sich mit Zensur im chinesischen Netzwerk Weibo. Zensierte Inhalte werden in neue Erfahrungen umgewandelt, Überwachung wird vermieden oder umgangen. Es stellt die Frage: Kann Technologie, die darauf abzielt, Informationen aus dem Internet zu entfernen, auch dazu verwendet werden, das Gelöschte unlöschbar zu machen?

Das Ars-Electronica-Festival blickt auf eine mittlerweile 40-jährige Geschichte zurück und fungiert seither als Fest und Vernetzungstreffen, Labor und Netzwerk, Ausstellung und Workshop. Je intensiver und detaillierter man versucht, dieses Festival zu beschreiben, desto eher sieht man sich daran scheitern. Sucht man aber nach dem diesjährigen Thema "Wem gehört die Wahrheit?" in Kunstwerken und Projekten, findet es sich in besonderer Qualität in den ausgezeichneten Werken wieder.

STANDARD: Geben Sie uns einen kurzen Einblick, worum es in der preisträchtigen Arbeit geht?

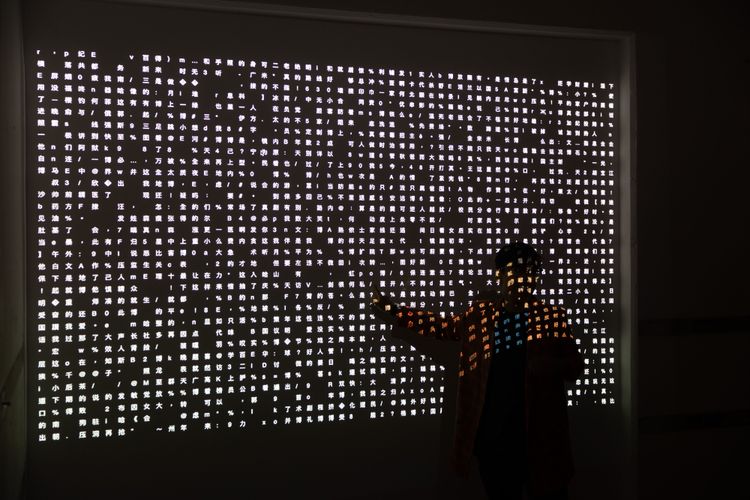

Soon: Das Kunstwerk besteht aus drei Teilen, einerseits in Form einer analogen Präsentation als Buch, andererseits einer Website und einer großflächigen Projektion. Die Projektion ist eine Art Livestream zensurierter Postings. Darin sind blinkende chinesische Zeichen in Zellen dargestellt. Jede Zelle wird zu einem Satz, die Schriftzeichen werden nacheinander eingeblendet. Alle basieren auf tausenden zensurierten Posts, gewonnen aus dem digitalen Netzwerk Weibo. Die Posts werden in ein Computermodell eingespeist, das mittels maschinellem Lernen Muster erkennt. Das Datum und auch der Inhalt sind sichtbar.

STANDARD: In der Projektion sind einige Zellen schwarz. Warum?

Soon: Die ausgeschwärzten Zellen stellen bereits zensurierte Posts dar – sie wurden innerhalb einer Sekunde oder in manchen Fällen erst innerhalb einiger Stunden zensuriert. In einigen Stunden werden mehr und mehr schwarze Zellen entstehen. Wenn alle Zellen schwarz sind, wurden auch alle Posts entfernt. Dann aktualisiert sich das Programm neu, und das digitale Kunstwerk beginnt von Neuem.

STANDARD: Sie machen gesperrte und gelöschte Inhalte sichtbar.

Soon: Die Idee dahinter ist nicht, dass man die Postings an sich liest, sondern eher darzustellen, welche Auswirkungen Algorithmen und maschinelles Lernen auf das tägliche Leben und Zensur haben. Wenn wir an maschinelles Lernen denken, sind wir stark davon beeinflusst, wie es große Tech-Unternehmen positionieren: als akkurat, präzise und produktiv. Kurz: als hilfreich für uns. Die Frage die ich mir stelle, ist: Ab welchem Moment ist die Technologie nicht mehr hilfreich?

STANDARD: Woher kommen die Daten für das Projekt?

Soon: Von "Weiboscope". Das ist ein Forschungsprojekt, ins Leben gerufen von King-wa Fu an der Universität Hongkong. Die Software erfasst die Timelines ausgewählter chinesischer User, die mehr als 1.000 Follower haben oder deren Beiträge häufig zensuriert werden. Dann prüft das Programm ständig: Ist der Post noch online? Sobald das System erkennt, dass ein Posting gelöscht wurde, fragt das System eigenständig bei Weibo: Warum wurde der Post gelöscht? Weibo gibt automatisiert Antworten und erklärt dann beispielsweise "Dieser Inhalt ist nicht erlaubt". Mit den Daten kann man also Zensur sichtbar machen.

STANDARD: Was bedeutet es eigentlich, Daten zu löschen?

Soon: Wenn Sie auf Ihrem eigenen Computer versehentlich etwas löschen, verlieren Sie die Datei. Gehen Sie aber direkt danach zu einer Datenexpertin, können die Daten wiederhergestellt werden. Dieser Aspekt von Daten hat mich interessiert: Können Dinge wirklich komplett gelöscht werden? Wenn wir das umlegen auf Zensur im digitalen Raum, ob das nun auf Weibo oder anderen sozialen Medien geschieht, erkennen wir: Auch wenn die Technik etwas löscht, ist es nicht vollständig verschwunden. Auf der Plattform unsichtbare Posts existieren weiterhin im System. Auch wenn wir als Nutzer es nicht sehen. Es geht also nicht nur darum, ob wir denken, dass etwas gelöscht wurde. Besonders interessant ist, wann und was gelöscht wurde.

STANDARD: Um es vereinfacht zu sagen, Sie erstellen ein Archiv aus gelöschten Posts. Mit dem Archiv werden diese Daten unlöschbar.

Soon: Ich versuche, Beziehungen zwischen Gelöschtem und Nichtlöschbarem zu zeigen.

STANDARD: Wenn wir uns nun mit Zensur beschäftigen: Macht es dann überhaupt Sinn, die Technologie selbst zu kritisieren? Oder wäre es besser, dahinterliegende Machtdynamiken zu kritisieren?

Soon: Für mich gibt es mehrere Ebenen. Die Infrastruktur rund um Zensurtechnik, die uns umgibt, arbeitet mit sogenannten Keywords. Listen mit diesen Wörtern kann man in China teilweise sogar online kaufen. Aber es geht noch viel weiter. Denn Zensur ist nicht nur eine automatisierte Arbeit, sie wird auch direkt von Menschen kontrolliert. Es ist unmöglich, diese beiden Stränge zu entwirren. Der Algorithmus ändert sich ständig: Einige Wörter, die heute verboten sind, könnten morgen erlaubt sein – sie sind beispielsweise abhängig von aktuellen politischen Debatten.

STANDARD: Es ist also auch eine Frage der jeweiligen Zeit.

Soon: Ähnlich wie Menschen sind auch Systeme des maschinellen Lernens abhängig davon, was in der Vergangenheit war. Sie arbeiten mit "alten" Daten. Es ist daher unmöglich, sich eine Zukunft ohne Vergangenheit vorzustellen.

STANDARD: In seinem Buch "Patterns" stellt der Soziologe Armin Nassehi die Frage: Warum gibt es "das Digitale" als System? Er stellt dann, grob gesagt, die These auf, dass es eine gesellschaftliche Notwendigkeit zur Digitalisierung gibt, da sie Struktur in die Welt bringt. Er versteht maschinelles Lernen auch als Antwort auf eine immer größer werdende Datenmenge, mit der kein Mensch mehr umgehen kann. Würden Sie ihm zustimmen?

Soon: Wir sind bereits mittendrin. Ohne Internetzugang oder Smartphone kann man in unserer Gesellschaft kaum mehr überleben oder zumindest produktiv teilnehmen. Das Digitale wurde zu einer Notwendigkeit. Ein Aspekt dabei ist aber im Prozess der Digitalisierung, dass es neue neoliberale Anwendungen ermöglicht. Das Konzept des Individuums, der Arbeit und der Wertschöpfung hat sich bereits stark verändert.

STANDARD: Ist in so einem System Privatsphäre überhaupt noch möglich? Selbstlernende Algorithmen brauchen riesige Mengen an Daten, um zu funktionieren, wir nutzen das Internet aber praktisch täglich und speisen so immer mehr Nutzerdaten ein.

Soon: Mittlerweile kenne ich einige, die keine Social Media mehr nutzen. Sie verwenden den verschlüsselten Browser Tor und VPN-Systeme, um ihren Standort und ihre Identität zu verschleiern, um anonym zu bleiben. Es gibt also einen Ausweg. Die Frage ist nur: Werden Sie das auch tun?

STANDARD: Wie meinen Sie das?

Soon: Es ist immer ein Kompromiss. Ich sehe aber auch in der EU einen positiven Einfluss, die Regeln werden strenger. Die EU versucht, verschiedene Formen von Datenschutzgesetzen und -vorschriften selbst zu etablieren. Aber die Technologie entwickelt sich zu schnell weiter. Meistens legt die Gesellschaft den Schwerpunkt auf Lösungen. Wir neigen dazu, Technologien zu veröffentlichen, die noch nicht ausgereift sind. Und dann heißt es oft: "Es tut uns sehr leid, dieser Algorithmus ist fehlerhaft." Ethische Fragen sind leider immer nur ein Zusatz.

STANDARD: Was ist so besonders an der Ars Electronica?

Soon: Kunst, Technologie und Gesellschaft werden zusammengedacht. Ich bin sehr erfreut, und zugegebenermaßen auch etwas überrascht, dieses Jahr Teil der Ars Electronica zu sein. Auch wenn meine Arbeit sich mit Problemen im asiatischen Kontext beschäftigt, hoffe ich, dass sich Besucherinnen und Besucher mit dem Thema angesprochen fühlen. Um die Technologien, die wir als Gesellschaft nutzen, zu hinterfragen. Dafür ist die Medienkunst eine äußerst wirksame Methode. (Sebastian Lang, 8.9.2023)