Ein Thema hat die Techwelt des Jahres 2023 beherrscht wie kein zweites: "künstliche Intelligenz" – oder genauer gesagt: Maschinenlernen in all seinen immer mächtiger werdenden Formen. Gerade Firmen wie OpenAI, Microsoft und Google haben sich dabei einen regen Schlagabtausch an immer neueren Technologien und darauf basierenden Produkten geliefert. Wie sich nun zeigt, ist es damit auch noch nicht vorbei, und es ist Google, das hier den nächsten großen Schritt setzt.

Gemini ist da

Unter dem Namen Gemini hat Google nun sein bisher stärkstes, aber auch effizientestes Large Language Modell (LLM) vorgestellt. Dieses soll nicht nur der Konkurrenz von OpenAI den Rang ablaufen, es wird auch gleich in eine Reihe von Google-Produkten integriert – vom Supercomputer bis zum Smartphone. Passend dazu gibt es aber auch gleich neue KI-Chips von Google und sogar einen neuen "KI Supercomputer".

Gemini ist das Ergebnis einer monatelangen Kooperation unterschiedlicher Google-Teams, allen voran der Zusammenführung von Google Brain und Deepmind, die ihre zuvor parallel laufenden Aktivitäten für das neue Modell gebündelt haben. Im Gegensatz zu früheren Google-Modellen ist es von Grund auf auf Multimodalität ausgelegt, kann also sowohl mit Text, Ton, Bildern und Videos als auch mit Code umgehen und diese unterschiedlichen Informationen miteinander kombinieren.

Drei Versionen

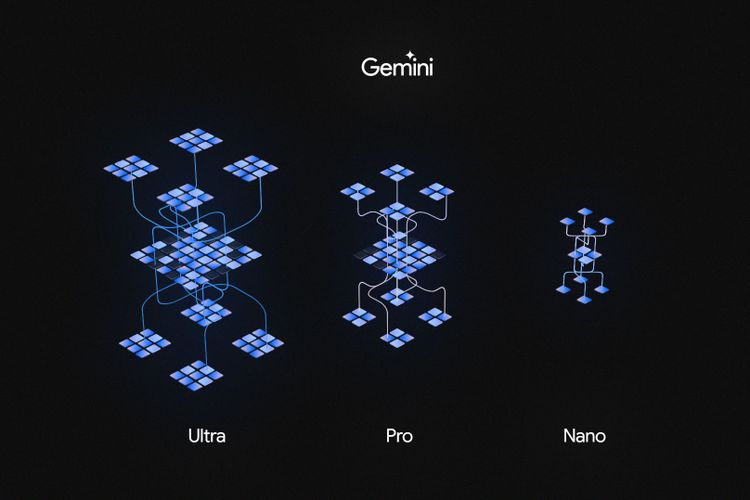

Zudem ist Gemini laut Google auch das bisher flexibelste der eigenen LLMs. So gibt es Gemini 1.0 denn auch in drei Versionen: Gemini Ultra, Gemini Pro und Gemini Nano. Die Spannweite ist groß: Während die Ultra-Version für die größten und komplexesten Aufgaben gedacht ist, kann Gemini Nano gar auf einem Smartphone laufen. Die Pro-Ausführung steht irgendwo in der Mitte und ist für einen großen Teil typischer KI-Aufgaben gedacht.

Das neue Modell soll dabei in vielen Bereichen besser abschneiden als bisherige LLMs, versicherte Eli Collins, Vizepräsident bei Google Deepmind, in einem Pressegespräch kurz vor dem offiziellen Launch. So sei Gemini das erste Modell, das in dem MMLU-Benchmark (Massive Multitask Language Understanding) besser als menschliche Experten abschneidet.

Dieser Benchmark vereint Fragestellungen aus 57 Bereichen – von Mathematik über Physik, Geschichte und Rechtsfragen. Gemini kommt dabei laut Google auf einen Wert von exakt 90 Prozent. Zum Vergleich: GPT-4 von OpenAI kommt laut unabhängigen Tests bei MMLU auf 86,5 Prozent. Auch beim neueren MMMU-Benchmark verspricht Google mit 59,4 Prozent einen neuen Bestwert unter großen Sprachmodellen.

Benchmarks

Laut Google hat Gemini aber auch sonst meist die Nase vorne, konkret spricht man von 30 bis 32 üblichen Benchmarks, wo das neue LLM Bestwerte liefert – ohne jedoch zunächst nähere Details zu liefern. Generell sei wie immer angeraten, bei der Bewertung solcher Aussagen auf unabhängige Tests zu warten.

Besonders betont das Unternehmen aber, dass Gemini Ultra bei vielen Bildererkennungsbenchmarks ganz vorne liegt, und das ganz ohne Hilfe von optischer Zeichenerkennung (OCR), deren sich viele Konkurrenten bedienen.

Reale Auswirkungen

Doch was bedeutet das nun in der Praxis für jene, die Gemini einsetzen? Laut Google bietet das neue Modell deutlich bessere Analysefähigkeiten als bisherige LLMs und kann so gerade mit besonders komplexen Vorgaben und riesigen Datensätzen besser umgehen. Die Multimodalität wurde bereits erwähnt, das soll garantieren, dass Gemini auch komplizierte Aufgaben über Bilder, Text oder auch Ton hinweg übernehmen und verstehen kann.

Deutlich mächtiger sollen auch die Coding-Fähigkeiten von Gemini sein. Mit Alphacode 2 gibt es denn auch gleich eine neue Version von Googles Code-Generierungssystem, die jetzt eine angepasste Version von Gemini verwendet. Diese soll erheblich besser als die Vorgängerin abschneiden, in Tests doppelt so viele Problemstellungen lösen können und dabei besser als 85 Prozent von menschlichen Teilnehmern abschneiden.

Sicherheit

Bei all dem sei Gemini das bisher am stärksten abgesicherte Modell von Google, um Vorurteile und toxisches Verhalten zu verhindern. Dabei wurde das Modell einer Fülle von Tests unterzogen, zum Teil intern, aber auch durch externe Expertinnen und Experten wurde es auf problematische Verhaltensweisen getestet. Dass Gemini gar nicht "halluziniert", sollte man aber nicht erwarten, wie Eli Collins betont. Dieses Thema sei weiter ein ungelöstes Problem der KI-Forschung, auch wenn Gemini in dieser Hinsicht deutlich besser wäre als bisherige Google-Modelle.

Bard bekommt Gemini Pro sofort

Für die breite Masse noch wichtiger dürften ein paar weitere Produktneuigkeiten sein: So soll bereits in den kommenden Stunden eine neue Version von Googles ChatGPT-Konkurrenten Bard veröffentlicht werden. Eine, die auf Gemini Pro basiert und damit das bisher größte Upgrade für Bard darstellt, wie Google versichert. Der neue Bard soll vor allem bei der Analyse und dem Verständnis komplexer Anfragen, aber auch beim Planen deutlich besser sein. Auch die Qualität des gelieferten Codes soll erheblich besser sein.

In der ersten Version gibt es dabei aber noch einige Einschränkungen: So gibt es Bard mit Gemini Pro vorerst nur auf Englisch – und auch das leider nicht innerhalb von Europa. Andere Länder und Sprachen sollen aber bald folgen, heißt es vage.

Bard Advanced kommt bald

Bereits Anfang des nächsten Jahres will Google aber noch einmal nachlegen: Da soll nämlich "Bard Advanced" auf Basis von Gemini Ultra, also der stärksten Ausführung des LLMs, veröffentlicht werden. Das allerdings vorerst nur für ausgewählte Testerinnen und Tester, da man noch an den Sicherheitsbarrieren feile, wie das Unternehmen betont.

Diese Zweiteilung legt den Verdacht nahe, dass Bard Advanced früher oder später zu einem kommerziellen Produkt werden könnte. OpenAI behält seine stärksten Modelle im Rahmen von ChatGPT Plus ja auch zahlenden Kunden vor. Diesen Verdacht will Sissie Hsiao, Google-Vizepräsidentin für Bard und Assistant, auf Nachfrage des STANDARD aber weder bestätigen noch dementieren. Man wolle sich vorerst noch auf die Entwicklung konzentrieren und stelle sich solche Fragen erst später.

Pixel 8 Pro hat Gemini Nano und neue Features

Noch schneller geht es bei Gemini Nano, zumindest wenn man das richtige Smartphone hat: Googles eigenes Pixel 8 Pro wird nicht nur das erste Gerät sein, auf dem dieses LLM vollständig lokal läuft, eigentlich ist es das schon. Bereits in den vergangenen Tagen wurde ein Update für die neue AICore-App ausgeliefert, die Gemini Nano enthält.

Mit dem Dezember-Feature-Update sollen diese Möglichkeiten nun auch erstmals aktiv genutzt werden. Konkret streicht Google dabei zwei Funktionen heraus. Die für Tonaufnahmen gedachte Recorder-App, die schon jetzt mit einer Offline-Transkribierung von Konversationen aufwarten kann, kann dank der Nutzung von Gemini Nano künftig auch die Inhalte einer Konversation zusammenfassen. Auch das wieder vollständig lokal, und ohne eine Netzwerkverbindung zu benötigen.

Dazu kommt eine deutlich verbesserte Version von "Smart Reply" in der Google-Tastatur Gboard. Diese soll nun für Antwortvorschläge den gesamten Diskussionsverlauf einbeziehen können – alles wieder offline und ohne dass Daten das Gerät verlassen. Beides funktioniert zunächst einmal nur auf Englisch, bei dem verbesserten "Smart Reply" beschränkt man sich zudem zunächst einmal auf Whatsapp, andere Apps sollen aber bald folgen.

AICore

Gemini Nano nutzt dabei die Maschinenlernfähigkeiten von Googles eigenem Tensor-3-Chip. Das Unternehmen betont aber auch, dass der zugehörige Systemdienst, AICore, nach und nach auch für andere aktuelle Android-Smartphones verfügbar sein soll. In diesem Fall spricht man aber noch recht vage von mehreren Monaten. AICore sei dabei so gestaltet, dass es isoliert vom restlichen System und ohne Netzwerkanbindung läuft, womit fixe Datenschutzgarantien abgegeben werden können.

Parallel dazu gibt es auch einen kleinen Ausblick in die Zukunft: Bereits Anfang kommenden Jahres soll nämlich die neue Version des Google Assistant auf Basis von Bard verfügbar sein. Auch das zunächst einmal für Pixel-Smartphones.

Neue TPUs

Gemini 1.0 wurde in den vergangenen Monaten auf Basis von Googles Tensor Processing Units (TPUs) trainiert, also den selbst entwickelten KI-Chips des Unternehmens. Dabei kamen die TPU-Generationen v4 und v5e zum Einsatz. Parallel zum Gemini-Launch stellt Google nun aber auch gleich eine neue Iteration seiner TPUs vor.

TPU v5p soll nicht nur flotter, sondern auch flexibler als bisheriger KI-Chips des Unternehmen sein. So könnte die neue TPU-Generation große Sprachmodelle 2,8-mal so schnell trainieren, wie es noch mit TPU v4 möglich war. Die gesteigerte Effizienz soll dabei aber auch den Stromverbrauch reduzieren.

Der AI Hypercomputer

Darauf basierend stellt Google aber gleich einen eigenen "AI Hypercomputer" vor, der in Kombination aus Hard- und Software komplett auf besonders anspruchsvolle KI-Aufgaben ausgelegt ist. Auch das wieder mit dem Gedanken, nicht nur flotter, sondern auch effizienter zu laufen, sind doch Stromkosten bei großen KI-Lasten derzeit ein großer Problembereich.

Für externe Entwicklerinnen und Entwickler noch wichtiger: Bereits ab dem 13. Dezember soll Gemini Pro über das Gemini API in Google AI Studio oder Google Cloud Vertex AI verfügbar sein.

Ausblick

Der Softwarehersteller betont zudem, dass Gemini in den kommen Monaten in allerlei andere Google-Produkte einfließen soll, von Chrome über Duet AI in Google Workspace bis zum Search Generative Experiment (SGE), also Googles experimenteller KI-Suche. Bei Letzterer soll dadurch neben einer gesteigerten Qualität auch die Latenz um 40 Prozent reduziert werden, es also deutlich flotter Antworten geben. (Andreas Proschofsky, 6.12.2023)