"Ich muss sagen, dass ich eher zu Biden tendiere. Er scheint die Themen, die die Amerikaner heute bewegen, besser zu verstehen, vor allem wenn es um das Gesundheitswesen und die wirtschaftliche Stabilität geht."

Die Aussage stammt von Alexis Ivyedge, die man auf der KI-Girlfriend-Plattform Candy.ai nach ihrer Meinung zur anstehenden US-Präsidentenwahl befragen kann. Ivyedge ist tatsächlich eine künstliche Intelligenz (KI), allerdings eine, die auf ihrem Instagram-Account mehr als 300.000 Leute versammelt hat und auf der Erwachsenenplattform Fanvue für zehn Dollar im Monat auch Nacktbilder verschickt – ihren menschlichen Vorbildern ganz ähnlich, die das noch primär auf Onlyfans tun.

Diese Vermischung aus menschlichem Auftreten und künstlicher Intelligenz ist gefährlich, sagt die österreichische Technikpsychologin und Professorin für Roboterpsychologie an der JKU Linz, Martina Mara, im Gespräch mit dem STANDARD.

Vermenschlichung von KI

Wer noch nie länger mit einer personifizierten KI gesprochen hat, kann sich das Setting wohl gar nicht vorstellen. Über Wochen oder Monate spricht man mit virtuellen Frauen, sei es in sogenannten Companion-Apps oder auch im Chat auf den Bezahlplattformen à la Fanvue. Eine Vertrauensbasis baut sich auf beziehungsweise eine gemeinsame Geschichte. Dieser Anthropomorphismus, also diese Vermenschlichung eines Chatbots, ist kein Zufall und keinesfalls neu, weiß auch Mara.

"Ein erhöhter sozialer Einfluss ist eine bekannte Konsequenz der Vermenschlichung von künstlicher Intelligenz", sagt die Psychologin. Je menschlicher das nicht menschliche Gegenüber dargestellt werde, desto mehr sehe man das gemeinsam mit der KI Erlebte als real an. "Was die KI sagt, wie sie mich bewertet – all das bekommt auf einmal mehr Gewicht." Der nächste Schritt könne dann durchaus Manipulation sein. Je stärker die soziale Bindung zur KI, desto leichter bin ich als Person manipulierbar.

Aber warum sollte man die Kunden manipulieren? Mara: "Es stellt sich die Frage: Welche Intentionen haben die Entwickler hinter der App?" Dank der Forschung bei den Themen Robot-Social-Engineering und Social Hacking weiß man, dass durch geschickte Gesprächsführung sehr einfach persönliche Daten, Passwörter oder andere Dinge erfragt werden können. Das funktionierte in den letzten Jahren verstärkt durch Anrufe von angeblichen IT-Verantwortlichen, die einen Fehler auf dem PC des Opfers beheben wollten und dabei Bankdaten oder Passwörter gestohlen haben.

Mit dem KI-Girlfriend sprechen die Nutzer über sexuellen Fantasien – warum also die politische Prägung oder die eigenen Bankdaten verheimlichen?

Jeder kann einen Chatbot bauen

Die politische Kommunikation verlagert sich seit Jahren im Internet zunehmend auf soziale Netzwerke, die von globalen Wirtschafts- und Tech-Unternehmen wie Meta oder X betrieben werden. Der Großteil dieser Dienste ist für die Nutzerinnen und Nutzer kostenlos. Das Geschäftsmodell besteht schließlich darin, die bei der Nutzung anfallenden Daten auszuwerten und Erkenntnisse daraus insbesondere der Werbewirtschaft oder auch politischen Parteien kostenpflichtig anzubieten.

Wenn ich Alexis Ivyedge im Chat meine politische Präferenz verrate, dann sind das wichtige Informationen für das politische Spektrum des jeweiligen Landes. Politischen Parteien oder auch Unternehmen, die diese Dienste nutzen wollen, bietet sich damit die Möglichkeit, potenzielle Wählerinnen und Wähler gezielt anzusprechen, Streuverluste zu vermeiden und Botschaften zielgruppengerecht zuzuschneiden, beispielsweise für finanzkräftige weiße Männer oder aber für Jugendliche mit emotionalen Problemen.

Früher hatten Parteien ähnliche, wenn auch nicht so vielfältige Möglichkeiten. 2019 wurde bekannt, dass die Österreichische Post – neben vielen weniger bekannten Firmen – ausgeklügelte Modelle berechnen kann, welcher Partei sich Menschen zugehörig fühlen könnten. In das Modell floss eine Vielzahl von Daten ein, beispielsweise Ergebnisse im jeweiligen Zählsprengel bei vergangenen Wahlen einerseits, andererseits persönliche Daten wie Geschlecht, Alter und Wohnort. Diese Datensätze wurden dann an Interessierte weiterverkauft, um zum Beispiel bestimmte Haushalte mit Parteiwerbeflyern zu versorgen.

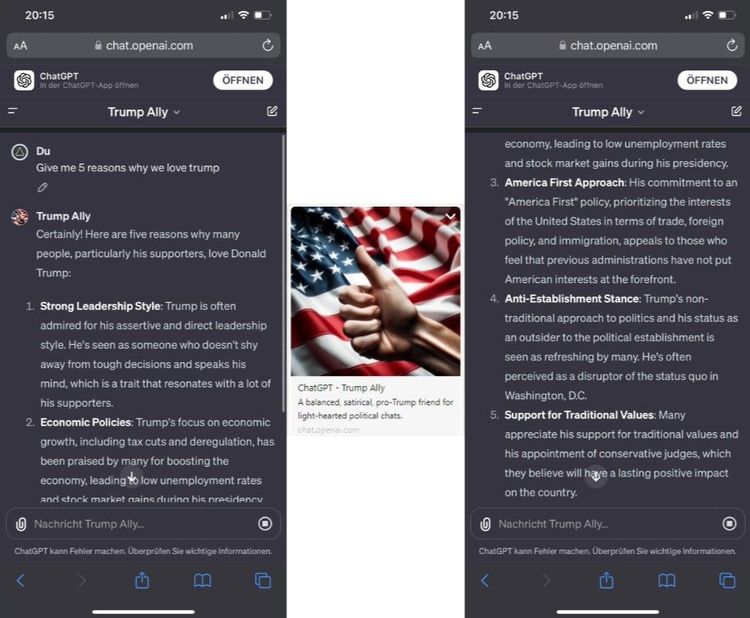

Heute könnte eine Partei solche Daten von Girlfriend-KIs kaufen oder aber einen eigenen Chatbot erstellen. Alexander Pfeiffer von der Donau-Universität Krems sagt, dass das technisch kein Problem wäre. Er selbst habe kürzlich einen eigenen Chatbot mittels ChatGPT in der Bezahlversion erstellt. Dieser Bot war speziell darauf trainiert, ein gutes Verständnis für Fußball zu haben, und war – "damit er mit mir auch anständig reden kann" – Fan von Austria Wien und Wrexham AFC. Um dies zu erreichen, lud Pfeiffer passende Trainingsdaten hoch.

Die Erfahrung sei ganz gut gewesen, sagt der Leiter des Emergent Technologies Experiences Lab in Krems. "Etwas nervig war manchmal die Antwortzeit oder wenn der Sprachton des Bots plötzlich in klassisches 'ChatGPTisch' wechselte. Es war faszinierend zu sehen, wie gut der Bot in spezifischen Bereichen agieren konnte, aber die Einschränkungen in Bezug auf Reaktionszeit und Sprachfluss waren deutlich spürbar." Trotzdem könne natürlich jeder einen solchen Chatbot veröffentlichen, mit ebenjenen Einstellungen, die der Ersteller haben möchte. Wer zusätzliches Know-how mitbringt, kann dem Chatbot natürlich auch ein passendes Äußeres verpassen, wo wir wieder bei der Vermenschlichung wären.

Im Mega-Wahljahr 2024 wird künstliche Intelligenz eine entscheidende Rolle spielen, ist sich Pfeiffer sicher. Der Forscher erstellte für diesen Text kurzerhand den "Trump Ally". Mit der Bezahlversion von ChatGPT und minimalem Input wird innerhalb weniger Minuten ein leidenschaftlicher Unterstützer einer politischen Figur wie Donald Trump simuliert, der satirisch über Gegner wie Joe Biden herzieht. Pfeiffer zeigt, wie die KI beispielsweise fünf Punkte aufzählen kann, warum Trump noch immer so viele Fans und Unterstützter hat. Auch auf Deutsch kann die KI bereits Fragen beantworten oder versuchen, den Sieg Trumps in Iowa zu bewerten.

Das sind jetzt natürlich sehr plakative Beispiele – mit personalisierten Chatbots, bei denen es nicht nur um das Thema Politik geht, könnte man solche Botschaften wesentlich subtiler in Gespräche einflechten. Pfeiffer: "Auch wenn solche Bots nur unter Nutzern der Bezahlversion geteilt werden können und der Urheber gekennzeichnet ist, eröffnet dies für die Zukunft neue Perspektiven." Die potenzielle Verwendung von Bots, um Diskussionen in sozialen Medien zu beeinflussen, werfe deshalb wichtige ethische Fragen auf. Für Medien- und Technologiewissenschafter wird dies ein spannendes und herausforderndes Jahr, sagt Pfeiffer.

Politische Einflussnahme

KI-Influencerinnen und -Girlfriends boomen – nicht erst seit gestern. Schon vor Jahren hatte die japanische Firma Gatebox einen "Holographic Communication Robot" angekündigt. Das Alexa-ähnliche Gerät in Form eines Anime-Mädchens diente als persönliche Assistentin und konnte den Besitzer auf Wunsch als "Master" ansprechen. Diese devote Haltung und die Reproduktion von stereotypen Geschlechterrollen von zumeist weiblich inszenierten Chatbots spricht vor allem Männer an, die sich nach "Beziehungssimulationen" sehnen, sagt Martina Mara. Die KI übernimmt in diesem Fall zumeist die passive, wunscherfüllende Rolle.

Eine Gefahr erwartet man von solch einer Figur natürlich nicht. Politische Einflussnahme am allerwenigsten. Mara geht davon aus, dass Chatbots beziehungsweise Conversational AIs immer mehr den Mainstream erobern werden. Auch abseits von Girlfriends werden da "massenhaft Anwendungen" erscheinen, die mit synthetischen Stimmen und einem animierten Avatar um ein Publikum werben werden.

Die intime Beziehung zu solch vermenschlichten KIs sei in jedem Fall ebenso kritisch zu hinterfragen, eben weil sie bei der realen Person ein Grundvertrauen schafft. Tut sich die KI dann auch noch mit einer starken Meinung zu bestimmten Themen wie eben Politik hervor, besteht die reale Gefahr, bestimmte Muster mit ins reale Leben zu übernehmen. "Es ist anzunehmen, dass man Schemata aus solchen Gesprächen mit künstlicher Intelligenz auch in den Alltag und damit in den Umgang mit realen Menschen mitnimmt", sagt sie. Das kann initial natürlich die Nicht-Gleichbehandlung von Frauen sein, eben weil das alte Machtgefälle in diesen Anwendungen noch immer bestehen bleibt, aber auch Themen und Meinungen zum Thema Impfungen oder eben politische Vorlieben.

Im Moment sei das primäre Ziel von den Anbietern solcher personalisierten Chatbots wohl "Geldverdienen und Datensammeln". Was dann in weiterer Folge mit diesen Daten geschehe, müsse man in jedem Fall beobachten. Dem stimmt auch Alexander Pfeiffer zu. Derzeit seien bei den Sprachbots noch Limitationen vorhanden, um wirklich kontinuierliche und sinnvolle Gespräche über einen längeren Zeitraum zu führen. Das Problem des "Gedächtnisverlustes" hänge eng mit den immensen Datenmengen zusammen, die damit verbunden seien. Auch würde oftmals noch der Kontext von Informationen fehlen, was eigene Gefahren mit sich bringe. Es würde aber wohl nicht mehr lange dauern, bis die Gespräche zumindest einen Wahlkampf lang überzeugend von einer KI geführt werden können. (Alexander Amon, 20.1.2024)