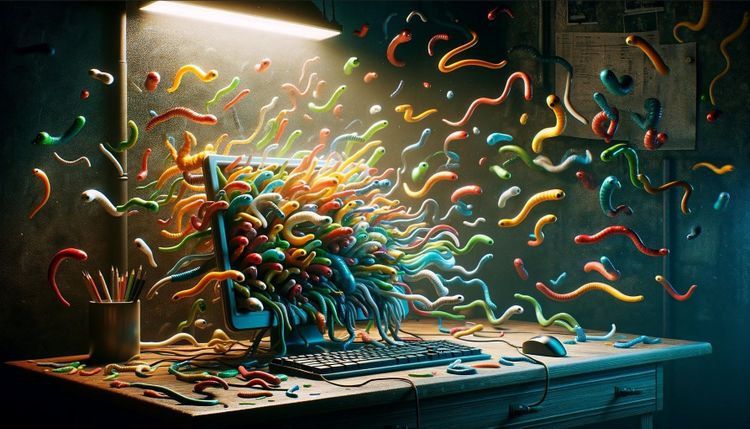

Wie jede moderne Technologie birgt generative künstliche Intelligenz (KI) neben großen Chancen – wenig überraschend – auch jede Menge Risiken. Dazu zählt offenbar auch eine neue Art von Computerwurm, wie Sicherheitsforscher der US-amerikanischen Cornell University und des israelischen Technion-Instituts nun unter Beweis gestellt haben. Dieser Wurm, in Anlehnung an den ersten Computerwurm "Morris II" getauft, nutzt das Konzept schädlicher, selbst replizierender Befehle, um sich in Ökosystemen von KI-Assistenten zu verbreiten.

Im Mittelpunkt der Untersuchung standen drei prominente KI-Modelle: Gemini Pro von Google, ChatGPT 4.0 von OpenAI und LLaVA, ein offenes Modell, das auf der LLaMA-Architektur basiert. Der Wurm kann nicht nur Sicherheitsvorkehrungen genannter Systeme umgehen. Die Forscher demonstrierten in einer Testumgebung, dass der Schädling auch in generative KI-gestützte Tools eindringen könnte, um etwa Daten zu stehlen oder Spam zu verbreiten.

Leichte Beute

Wie "Wired" berichtete, gelang es Forschern mit dieser Methode am Beispiel eines E-Mail-Assistenten, sensible Daten wie Namen, Telefonnummern und Kreditkarteninformationen einfach aus Nachrichten zu extrahieren. Sie veröffentlichten ihre Ergebnisse in einer ausführlichen Studie und demonstrierten ihre Erkenntnisse auch in einem Video auf ihrer Webseite.

"Die Studie zeigt, dass Angreifer Anweisungen in die Eingabefelder einfügen können, die, wenn sie von einem GenAI-Modell verarbeitet werden, dieses dazu veranlassen, die Eingabe als Ausgabe zu replizieren und bösartige Aktivitäten auszuführen", wird ausgeführt. Diese manipulierten Eingaben können sich innerhalb eines KI-Ökosystems ausbreiten, indem sie von einem Assistenten zum anderen weitergeleitet werden. Die Forscher ziehen dabei Parallelen zwischen dieser Methode und bekannten Cyberangriffstechniken wie der SQL-Injection und dem Buffer Overflow.

OpenAI reagiert, Google schweigt

Nachdem ihre Angriffe Erfolg gezeigt hatten, nahm das Forscherteam Kontakt zu OpenAI und Google auf, um sie über ihre Entdeckungen zu informieren. OpenAI reagierte daraufhin mit der Zusage, die Sicherheit ihrer Systeme weiter zu verstärken, und appellierte an die Entwicklergemeinschaft, Vorsichtsmaßnahmen zu treffen, um die Verarbeitung potenziell schädlicher Daten zu vermeiden. Google hat bislang noch keine Stellungnahme zu den Forschungsergebnissen abgegeben.

Die Forscher prognostizieren, dass innerhalb der nächsten zwei bis drei Jahre ähnliche KI-Würmer in realen Anwendungsszenarien auftauchen könnten, was die Notwendigkeit unterstreicht, sich mit diesen neuen Sicherheitsrisiken auseinanderzusetzen und entsprechende Schutzmaßnahmen zu entwickeln. (red, 5.3.2024)